diff --git a/chapters/th/_toctree.yml b/chapters/th/_toctree.yml

index 5139c38b7..b473ea93c 100644

--- a/chapters/th/_toctree.yml

+++ b/chapters/th/_toctree.yml

@@ -104,4 +104,26 @@

title: เรียนจบเรื่อง tokenizer แล้ว!

- local: chapter6/10

title: คำถามท้ายบท

- quiz: 6

\ No newline at end of file

+ quiz: 6

+

+- title: 7. หน้าที่หลักของ NLP

+ sections:

+ - local: chapter7/1

+ title: บทนำ

+ - local: chapter7/2

+ title: การจำแนกประเภทคำ (Token classification)

+ - local: chapter7/3

+ title: การปรับแต่งโมเดลภาษา (Fine-tuning a masked language model)

+ - local: chapter7/4

+ title: การแปลความหมาย

+ - local: chapter7/5

+ title: การสรุปความหมาย (Summarization)

+ - local: chapter7/6

+ title: การเทร็นภาษาเชิงสาเหตุตั้งแต่เริ่มต้น (Training a causal language model from scratch)

+ - local: chapter7/7

+ title: การตอบคำถาม (Question answering)

+ - local: chapter7/8

+ title: การเชี่ยวชาญใน NLP

+ - local: chapter7/9

+ title: คำถามท้ายบท

+ quiz: 7

\ No newline at end of file

diff --git a/chapters/th/chapter7/1.mdx b/chapters/th/chapter7/1.mdx

new file mode 100644

index 000000000..8f4f261a5

--- /dev/null

+++ b/chapters/th/chapter7/1.mdx

@@ -0,0 +1,38 @@

+

+

+# บทนำ[[บทนำ]]

+

+

+

+ใน [บทที่ 3](/course/th/chapter3), คุณได้เห็นวิธีการปรับแต่งโมเดลสำหรับการจัดหมวดหมู่ข้อความแล้ว ในบทนี้ เราจะพูดถึงหน้าที่ NLP โดยทั่วไป ดังนี้:

+

+- การจำแนกประเภทคำ (Token classification)

+- การปรับแต่งโมเดลภาษา (Masked language modeling) เช่น BERT

+- การสรุปความหมาย (Summarization)

+- การแปลความหมาย (Translation)

+- โมเดลภาษาเชิงสาเหตุ (Causal language modeling pretraining) เช่น GPT-2

+- การตอบคำถาม (Question answering)

+

+{#if fw === 'pt'}

+

+ในการดำเนินการนี้ คุณจะต้องใช้ประโยชน์จากทุกสิ่งที่คุณได้เรียนรู้เกี่ยวกับ `Trainer` API และ 🤗 Accelerate ไลบรารี่ใน [บทที่ 3](/course/th/chapter3) ไลบรารี 🤗 ชุดข้อมูลใน [บทที่ 5](/course/th/chapter5 ) และไลบรารี 🤗 Tokenizers ใน [บทที่ 6](/course/th/chapter6) นอกจากนี้เรายังจะอัปโหลดผลลัพธ์ของเราไปยัง Model Hub เช่นเดียวกับที่เราทำใน [บทที่ 4](/course/th/chapter4) ดังนั้นนี่คือบทที่ทุกอย่างมารวมกันจริงๆ!

+

+แต่ละส่วนสามารถอ่านแยกกันได้ และจะแสดงวิธีฝึกโมเดลด้วย `Trainer` API หรือด้วยลูปการฝึกของคุณเอง โดยใช้ 🤗 Accelerate คุณสามารถข้ามส่วนใดส่วนหนึ่งและมุ่งความสนใจไปที่ส่วนที่คุณสนใจมากที่สุดได้เลย: `Trainer` API นั้นยอดเยี่ยมสำหรับการปรับแต่ง (fine-tuning) หรือฝึกฝน (training) โมเดลของคุณโดยไม่ต้องกังวลกับสิ่งที่เกิดขึ้นเบื้องหลัง ในขณะที่ลูปการฝึกฝนด้วย `Accelerate` จะช่วยให้คุณปรับแต่งส่วนใด ๆ ที่คุณต้องการได้ง่ายขึ้น

+

+{:else}

+

+ในการดำเนินการนี้ คุณจะต้องใช้ประโยชน์จากทุกสิ่งที่คุณได้เรียนรู้เกี่ยวกับโมเดลการฝึกอบรมด้วย Keras API ใน [บทที่ 3](/course/th/chapter3) ไลบรารี 🤗 ชุดข้อมูลใน [บทที่ 5](/course/th/chapter5) และ 🤗 ไลบรารี Tokenizers ใน [บทที่ 6](/course/th/chapter6) นอกจากนี้เรายังจะอัปโหลดผลลัพธ์ของเราไปยัง Model Hub เช่นเดียวกับที่เราทำใน [บทที่ 4](/course/th/chapter4) ดังนั้นนี่คือบทที่ทุกอย่างมารวมกันจริงๆ!

+

+แต่ละส่วนสามารถอ่านได้อย่างอิสระ

+

+{/if}

+

+

+

+

+หากคุณอ่านส่วนต่างๆ ตามลำดับ คุณจะสังเกตเห็นว่ามีโค้ดและข้อความค่อนข้างเหมือนกัน การทำซ้ำนี้ มีเจตนาเพื่อให้คุณสามารถเข้าไปทำงานใดๆ ที่คุณสนใจ (หรือกลับมาใหม่ทีหลัง) และค้นหาตัวอย่างการทำงานที่สมบูรณ์ได้

+

+

diff --git a/chapters/th/chapter7/2.mdx b/chapters/th/chapter7/2.mdx

new file mode 100644

index 000000000..a48fe5d31

--- /dev/null

+++ b/chapters/th/chapter7/2.mdx

@@ -0,0 +1,981 @@

+

+

+# การจำแนกประเภทคำ[[การจำแนกประเภทคำ]]

+

+{#if fw === 'pt'}

+

+

+

+{:else}

+

+

+

+{/if}

+

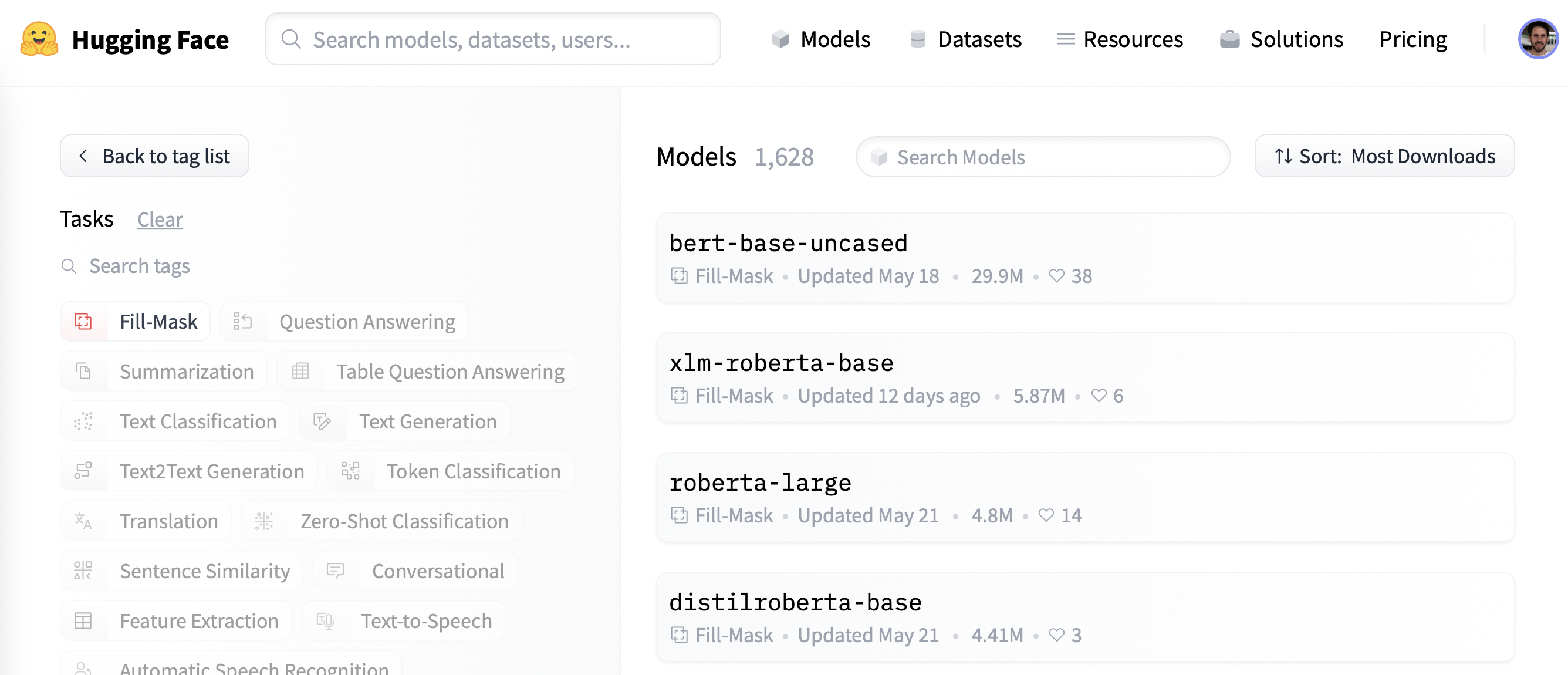

+แอปพลิเคชันแรกที่เราจะสำรวจคือการจำแนกคำ งานทั่วไปนี้ครอบคลุมปัญหาใดๆ ที่สามารถกำหนดเป็น "การกำหนดป้ายกำกับให้กับแต่ละคำในประโยค" เช่น:

+

+- **Named entity recognition (NER)**: ค้นหาเอนทิตี (เช่น บุคคล สถานที่ หรือองค์กร) ในประโยค สิ่งนี้สามารถกำหนดเป็นการกำหนดป้ายกำกับให้กับแต่ละคำโดยมีหนึ่งคลาสต่อเอนทิตีและหนึ่งคลาสสำหรับ "ไม่มีเอนทิตี"

+- **Part-of-speech tagging (POS)**: ทำเครื่องหมายแต่ละคำในประโยคว่าสอดคล้องกับส่วนของคำพูด (เช่น คำนาม กริยา คำคุณศัพท์ ฯลฯ)

+- **Chunking**: ค้นหาคำ (token) ที่เป็นของเอนทิตีเดียวกัน งานนี้ (ซึ่งสามารถใช้ร่วมกับ POS หรือ NER) สามารถกำหนดเป็นป้ายกำกับ (label) เดียว (โดยปกติคือ `B-`) ให้กับคำใด ๆ ที่อยู่ที่จุดเริ่มต้นของก้อน และอีกป้ายกำกับหนึ่ง (โดยปกติคือ `I-`) ให้กับคำที่ อยู่ภายในก้อนข้อมูล และป้ายกำกับที่สาม (โดยปกติคือ `O`) ของคำที่ไม่ได้เป็นของก้อนใดก้อนหนึ่ง

+

+

+

+แน่นอนว่ามีปัญหาการจำแนกคำประเภทอื่นๆ อีกหลายประเภท นี่เป็นเพียงตัวอย่างบางส่วนเท่านั้น ในส่วนนี้ เราจะปรับแต่งโมเดล (BERT) ในงาน NER ซึ่งจะสามารถคำนวณการคาดการณ์เช่นนี้ได้:

+

+

+

+

+ +

+ +

+

+คุณค้นหาโมเดลที่เราจะฝึกและอัปโหลดไปยัง Hub และตรวจสอบการคาดการณ์อีกครั้งได้ [ที่นี่](https://huggingface.co/huggingface-course/bert-finetuned-ner?text=My+name+is+Sylvain+and+I+work+at+Hugging+Face+in+Brooklyn).

+

+## การเตรียมข้อมูล[[การเตรียมข้อมูล]]

+

+ก่อนอื่น เราต้องการชุดข้อมูลที่เหมาะสำหรับการจำแนกคำ ในส่วนนี้ เราจะใช้ [CoNLL-2003 dataset](https://huggingface.co/datasets/conll2003) ซึ่งรวบรวมข่าวจาก Reuters

+

+

+

+💡 ตราบใดที่ชุดข้อมูลของคุณประกอบด้วยข้อความที่แบ่งออกเป็นคำโดยมีป้ายกำกับที่เกี่ยวข้อง คุณจะสามารถปรับขั้นตอนการประมวลผลข้อมูลที่อธิบายไว้ที่นี่กับชุดข้อมูลของคุณเองได้ ย้อนกลับไปที่ [บทที่ 5](/course/th/chapter5) หากคุณต้องการทบทวนวิธีโหลดข้อมูลที่คุณกำหนดเองใน `ชุดข้อมูล`

+

+

+

+### The CoNLL-2003 dataset[[the-conll-2003-dataset]]

+

+ในการโหลดชุดข้อมูล CoNLL-2003 เราใช้เมธอด `load_dataset()` จากไลบรารี 🤗 ชุดข้อมูล:

+

+```py

+from datasets import load_dataset

+

+raw_datasets = load_dataset("conll2003")

+```

+

+การดำเนินการนี้จะดาวน์โหลดและแคชชุดข้อมูล ดังที่เราเห็นใน [บทที่ 3](/course/th/chapter3) สำหรับชุดข้อมูล GLUE MRPC การตรวจสอบออบเจ็กต์นี้จะแสดงให้เราเห็นคอลัมน์ที่มีอยู่และการแบ่งระหว่างชุดการฝึก การตรวจสอบ และการทดสอบ:

+

+```py

+raw_datasets

+```

+

+```python out

+DatasetDict({

+ train: Dataset({

+ features: ['chunk_tags', 'id', 'ner_tags', 'pos_tags', 'tokens'],

+ num_rows: 14041

+ })

+ validation: Dataset({

+ features: ['chunk_tags', 'id', 'ner_tags', 'pos_tags', 'tokens'],

+ num_rows: 3250

+ })

+ test: Dataset({

+ features: ['chunk_tags', 'id', 'ner_tags', 'pos_tags', 'tokens'],

+ num_rows: 3453

+ })

+})

+```

+

+โดยเฉพาะอย่างยิ่ง เราจะเห็นว่าชุดข้อมูลมีป้ายกำกับ (label) สำหรับงานสามอย่างที่เรากล่าวถึงก่อนหน้านี้: NER, POS และ chunking จะเห็นว่าความแตกต่างอย่างมากจากชุดข้อมูลอื่นๆ ก็คือข้อความที่ป้อนไม่ได้ถูกนำเสนอเป็นประโยคหรือเอกสาร แต่เป็นรายการของคำ (คอลัมน์สุดท้ายเรียกว่า `โทเค็น` แต่มีคำในแง่ที่ว่าสิ่งเหล่านี้เป็นอินพุตโทเค็นล่วงหน้าที่ยังคงต้องการ เพื่อผ่านโทเค็นไนเซอร์สำหรับโทเค็นคำย่อย)

+

+มาดูองค์ประกอบแรกของชุดการฝึกกันดีกว่า:

+

+```py

+raw_datasets["train"][0]["tokens"]

+```

+

+```python out

+['EU', 'rejects', 'German', 'call', 'to', 'boycott', 'British', 'lamb', '.']

+```

+

+เนื่องจากเราต้องการดำเนินการจดจำเอนทิตีที่มีชื่อ เราจะดูที่แท็ก NER:

+

+```py

+raw_datasets["train"][0]["ner_tags"]

+```

+

+```python out

+[3, 0, 7, 0, 0, 0, 7, 0, 0]

+```

+

+สิ่งเหล่านี้คือป้ายกำกับว่าเป็นจำนวนเต็มพร้อมสำหรับการฝึก แต่ก็ไม่จำเป็นเสมอไปเมื่อเราต้องการตรวจสอบข้อมูล เช่นเดียวกับการจัดหมวดหมู่ข้อความ เราสามารถเข้าถึงความสอดคล้องระหว่างจำนวนเต็มเหล่านั้นกับชื่อป้ายกำกับได้โดยดูที่แอตทริบิวต์ `features` ของชุดข้อมูลของเรา:

+

+```py

+ner_feature = raw_datasets["train"].features["ner_tags"]

+ner_feature

+```

+

+```python out

+Sequence(feature=ClassLabel(num_classes=9, names=['O', 'B-PER', 'I-PER', 'B-ORG', 'I-ORG', 'B-LOC', 'I-LOC', 'B-MISC', 'I-MISC'], names_file=None, id=None), length=-1, id=None)

+```

+

+ดังนั้นคอลัมน์นี้จึงมีองค์ประกอบที่เป็นลำดับของ `ClassLabel`s ประเภทขององค์ประกอบของลำดับอยู่ในแอตทริบิวต์ `feature` ของ `ner_feature` นี้ และเราสามารถเข้าถึงรายชื่อได้โดยดูที่แอตทริบิวต์ `names` ของ `feature` นั้น:

+

+```py

+label_names = ner_feature.feature.names

+label_names

+```

+

+```python out

+['O', 'B-PER', 'I-PER', 'B-ORG', 'I-ORG', 'B-LOC', 'I-LOC', 'B-MISC', 'I-MISC']

+```

+

+เราเห็นป้ายกำกับ (label) เหล่านี้แล้วเมื่อเจาะลึกไปป์ไลน์ `การจำแนกคำ` ใน [บทที่ 6](/course/th/chapter6/3) แต่เพื่อการทบทวนอย่างรวดเร็ว:

+

+- `O` หมายความว่าคำนี้ไม่สอดคล้องกับเอนทิตีใด ๆ

+- `B-PER`/`I-PER` หมายถึงคำที่ตรงกับจุดเริ่มต้นของ หรือ อยู่ภายในเอนทิตี *บุคคล*

+- `B-ORG`/`I-ORG` หมายถึงคำที่ตรงกับจุดเริ่มต้นของ หรือ อยู่ภายในเอนทิตี *องค์กร*

+- `B-LOC`/`I-LOC` หมายถึงคำที่สอดคล้องกับจุดเริ่มต้นของ หรือ อยู่ภายในเอนทิตี *สถานที่*

+- `B-MISC`/`I-MISC` หมายถึงคำที่สอดคล้องกับจุดเริ่มต้นของ หรือ อยู่ภายในเอนทิตี *เบ็ดเตล็ด*

+

+มาดูการถอดรหัสป้ายกำกับที่เราเห็นก่อนหน้านี้ ซึ่งทำให้เราได้สิ่งนี้:

+

+```python

+words = raw_datasets["train"][0]["tokens"]

+labels = raw_datasets["train"][0]["ner_tags"]

+line1 = ""

+line2 = ""

+for word, label in zip(words, labels):

+ full_label = label_names[label]

+ max_length = max(len(word), len(full_label))

+ line1 += word + " " * (max_length - len(word) + 1)

+ line2 += full_label + " " * (max_length - len(full_label) + 1)

+

+print(line1)

+print(line2)

+```

+

+```python out

+'EU rejects German call to boycott British lamb .'

+'B-ORG O B-MISC O O O B-MISC O O'

+```

+

+และสำหรับตัวอย่างการผสมป้ายกำกับ `B-` และ `I-` นี่คือสิ่งที่โค้ดเดียวกันนี้ให้กับองค์ประกอบของชุดการฝึกที่ดัชนี 4:

+

+```python out

+'Germany \'s representative to the European Union \'s veterinary committee Werner Zwingmann said on Wednesday consumers should buy sheepmeat from countries other than Britain until the scientific advice was clearer .'

+'B-LOC O O O O B-ORG I-ORG O O O B-PER I-PER O O O O O O O O O O O B-LOC O O O O O O O'

+```

+

+ดังที่เราเห็น เอนทิตีที่ประกอบด้วยคำสองคำ เช่น "European Union" และ "Werner Zwingmann" จะถูกจัดว่าเป็นป้ายกำกับ `B-` สำหรับคำแรก และป้ายกำกับ 'I-` สำหรับคำที่สอง

+

+

+

+✏️ **ถึงตาคุณแล้ว!** พิมพ์สองประโยคเดียวกันด้วย POS หรือป้ายกำกับแบบแยกส่วน

+

+

+

+### การประมวลผลข้อมูล[[การประมวลผลข้อมูล]]

+

+

+

+ตามปกติ ข้อความของเราต้องแปลงเป็นรหัสโทเค็นก่อนที่โมเดลจะเข้าใจได้ ดังที่เราเห็นใน [บทที่ 6](/course/th/chapter6/) ความแตกต่างที่สำคัญในกรณีของงานการจำแนกโทเค็นก็คือ เรามีอินพุตโทเค็นล่วงหน้า โชคดีที่ tokenizer API สามารถจัดการกับสิ่งนั้นได้อย่างง่ายดาย เราแค่ต้องเตือน `tokenizer` ด้วยแฟล็กพิเศษ

+

+ขั้นแรก เรามาสร้างออบเจ็กต์ `tokenizer` กัน ดังที่เราได้กล่าวไว้ก่อนหน้านี้ เราจะใช้โมเดลที่ได้รับการฝึกล่วงหน้าของ BERT ดังนั้นเราจะเริ่มต้นด้วยการดาวน์โหลดและแคชโทเค็นไนเซอร์ที่เกี่ยวข้อง:

+

+```python

+from transformers import AutoTokenizer

+

+model_checkpoint = "bert-base-cased"

+tokenizer = AutoTokenizer.from_pretrained(model_checkpoint)

+```

+

+คุณสามารถแทนที่ `model_checkpoint` ด้วยโมเดลอื่นใดก็ได้ที่คุณต้องการจาก [Hub](https://huggingface.co/models) หรือด้วยโฟลเดอร์ในเครื่องที่คุณได้บันทึกโมเดลที่ฝึกไว้ล่วงหน้าและ tokenizer. มีข้อจำกัดเพียงอย่างเดียวคือโทเค็นต้องได้รับการสนับสนุนโดยไลบรารี 🤗 Tokenizers ดังนั้นจึงมีเวอร์ชัน "fast" ให้ใช้งาน คุณสามารถดูสถาปัตยกรรมทั้งหมดที่มาพร้อมกับเวอร์ชันที่รวดเร็วได้ใน [ตารางใหญ่นี้](https://huggingface.co/transformers/#supported-frameworks) และเพื่อตรวจสอบว่าวัตถุ `tokenizer` ที่คุณใช้อยู่นั้นเป็นจริง สนับสนุนโดย 🤗 Tokenizers คุณสามารถดูแอตทริบิวต์ `is_fast` ได้:

+

+```py

+tokenizer.is_fast

+```

+

+```python out

+True

+```

+

+หากต้องการโทเค็นอินพุตที่แปลงเป็นโทเค็นล่วงหน้า (a pre-tokenized input) เราสามารถใช้ `tokenizer` ตามปกติและเพียงเพิ่ม `is_split_into_words=True`:

+

+```py

+inputs = tokenizer(raw_datasets["train"][0]["tokens"], is_split_into_words=True)

+inputs.tokens()

+```

+

+```python out

+['[CLS]', 'EU', 'rejects', 'German', 'call', 'to', 'boycott', 'British', 'la', '##mb', '.', '[SEP]']

+```

+

+ดังที่เราเห็น Tokenizer ได้เพิ่มโทเค็นพิเศษที่ใช้โดยโมเดล (`[CLS]` ที่จุดเริ่มต้นและ `[SEP]` ในตอนท้าย) และปล่อยให้คำส่วนใหญ่ไม่ถูกแตะต้อง อย่างไรก็ตาม คำว่า `lamb` ถูกแปลงเป็นคำย่อย 2 คำ คือ `la` และ `##mb` สิ่งนี้ทำให้เกิดความไม่ตรงกันระหว่างอินพุตของเราและป้ายกำกับ: รายการป้ายกำกับมีเพียง 9 องค์ประกอบ ในขณะที่อินพุตของเราตอนนี้มี 12 โทเค็น การบัญชีสำหรับโทเค็นพิเศษเป็นเรื่องง่าย (เรารู้ว่ามันอยู่ที่จุดเริ่มต้นและจุดสิ้นสุด) แต่เรายังต้องตรวจสอบให้แน่ใจด้วยว่าเราจัดตำแหน่งป้ายกำกับทั้งหมดด้วยคำที่เหมาะสม

+

+โชคดีมาก เนื่องจากเราใช้ tokenizer ที่รวดเร็ว เราจึงสามารถเข้าถึง 🤗 Tokenizers มหาอำนาจได้ ซึ่งหมายความว่าเราสามารถจับคู่โทเค็นแต่ละโทเค็นกับคำที่เกี่ยวข้องได้อย่างง่ายดาย (ดังที่เห็นใน [บทที่ 6](/course/th/chapter6/3)):

+

+```py

+inputs.word_ids()

+```

+

+```python out

+[None, 0, 1, 2, 3, 4, 5, 6, 7, 7, 8, None]

+```

+

+ด้วยการทำงานเพียงเล็กน้อย เราก็สามารถขยายรายการป้ายกำกับของเราให้ตรงกับโทเค็นได้ กฎข้อแรกที่เราจะใช้คือโทเค็นพิเศษจะมีป้ายกำกับ `-100` เนื่องจากโดยค่าเริ่มต้น `-100` คือดัชนีที่ถูกละเว้นในฟังก์ชันการสูญเสีย (loss function) ที่เราจะใช้ (cross entropy) จากนั้น แต่ละโทเค็นจะมีป้ายกำกับเดียวกันกับโทเค็นที่ขึ้นต้นด้วยคำว่าอยู่ข้างใน เนื่องจากเป็นส่วนหนึ่งของเอนทิตีเดียวกัน สำหรับโทเค็นที่อยู่ในคำ แต่ไม่ใช่ที่จุดเริ่มต้น เราจะแทนที่ `B-` ด้วย `I-` (เนื่องจากโทเค็นไม่ได้ขึ้นต้นเอนทิตี):

+

+```python

+def align_labels_with_tokens(labels, word_ids):

+ new_labels = []

+ current_word = None

+ for word_id in word_ids:

+ if word_id != current_word:

+ # Start of a new word!

+ current_word = word_id

+ label = -100 if word_id is None else labels[word_id]

+ new_labels.append(label)

+ elif word_id is None:

+ # Special token

+ new_labels.append(-100)

+ else:

+ # Same word as previous token

+ label = labels[word_id]

+ # If the label is B-XXX we change it to I-XXX

+ if label % 2 == 1:

+ label += 1

+ new_labels.append(label)

+

+ return new_labels

+```

+

+เรามาลองใช้ประโยคแรกกันดีกว่า:

+

+```py

+labels = raw_datasets["train"][0]["ner_tags"]

+word_ids = inputs.word_ids()

+print(labels)

+print(align_labels_with_tokens(labels, word_ids))

+```

+

+```python out

+[3, 0, 7, 0, 0, 0, 7, 0, 0]

+[-100, 3, 0, 7, 0, 0, 0, 7, 0, 0, 0, -100]

+```

+

+ดังที่เราเห็น ฟังก์ชั่นของเราเพิ่ม `-100` สำหรับโทเค็นพิเศษสองตัวที่จุดเริ่มต้นและจุดสิ้นสุด และ `0` ใหม่สำหรับคำของเราที่แบ่งออกเป็นสองโทเค็น

+

+

+

+✏️ **ถึงตาคุณทดลองแล้ว!** นักวิจัยบางคนชอบที่จะระบุป้ายกำกับเพียง 1 ป้ายต่อคำ และกำหนด `-100` ให้กับโทเค็นย่อยอื่นๆ ในคำที่กำหนด นี่คือการหลีกเลี่ยงคำยาวๆ ที่แบ่งออกเป็นโทเค็นย่อยจำนวนมากซึ่งมีส่วนทำให้เกิดการสูญเสียอย่างมาก เปลี่ยนฟังก์ชันก่อนหน้าเพื่อจัดแนวป้ายกำกับกับ ID อินพุตโดยปฏิบัติตามกฎนี้

+

+

+

+ในการประมวลผลชุดข้อมูลทั้งหมดของเราล่วงหน้า เราจำเป็นต้องแปลงโทเค็นอินพุตทั้งหมดและใช้ `align_labels_with_tokens()` กับป้ายกำกับทั้งหมด เพื่อใช้ประโยชน์จากความเร็วของโทเค็นเซอร์ที่รวดเร็วของเรา วิธีที่ดีที่สุดคือโทเค็นข้อความจำนวนมากในเวลาเดียวกัน ดังนั้นเราจะเขียนฟังก์ชันที่ประมวลผลรายการตัวอย่างและใช้เมธอด `Dataset.map()` พร้อมตัวเลือก `batched=True` สิ่งเดียวที่แตกต่างจากตัวอย่างก่อนหน้านี้คือฟังก์ชัน `word_ids()` จำเป็นต้องได้รับดัชนีของตัวอย่างที่เราต้องการ ID คำเมื่ออินพุตไปยังโทเค็นไนเซอร์เป็นรายการข้อความ (หรือในกรณีของเรา รายการ ของรายการคำศัพท์) เราก็เลยเพิ่มเข้าไปด้วย:

+

+```py

+def tokenize_and_align_labels(examples):

+ tokenized_inputs = tokenizer(

+ examples["tokens"], truncation=True, is_split_into_words=True

+ )

+ all_labels = examples["ner_tags"]

+ new_labels = []

+ for i, labels in enumerate(all_labels):

+ word_ids = tokenized_inputs.word_ids(i)

+ new_labels.append(align_labels_with_tokens(labels, word_ids))

+

+ tokenized_inputs["labels"] = new_labels

+ return tokenized_inputs

+```

+

+โปรดทราบว่าเรายังไม่ได้เพิ่มอินพุตของเรา เราจะดำเนินการดังกล่าวในภายหลัง เมื่อสร้างแบทช์ด้วยตัวรวบรวมข้อมูล

+

+ตอนนี้เราสามารถใช้การประมวลผลล่วงหน้าทั้งหมดนั้นในคราวเดียวกับการแยกชุดข้อมูลอื่นๆ ของเรา:

+

+```py

+tokenized_datasets = raw_datasets.map(

+ tokenize_and_align_labels,

+ batched=True,

+ remove_columns=raw_datasets["train"].column_names,

+)

+```

+

+เราได้ทำส่วนที่ยากที่สุดแล้ว! เมื่อข้อมูลได้รับการประมวลผลล่วงหน้าแล้ว การฝึกอบรมจริงจะมีลักษณะเหมือนกับที่เราทำใน [บทที่ 3](/course/th/chapter3) มาก

+

+{#if fw === 'pt'}

+

+## ปรับแต่งโมเดลอย่างละเอียดด้วย `Trainer` API

+

+โค้ดจริงที่ใช้ `Trainer` จะเหมือนกับเมื่อก่อน การเปลี่ยนแปลงเพียงอย่างเดียวคือวิธีการจัดเรียงข้อมูลเป็นชุดและฟังก์ชันการคำนวณหน่วยเมตริก

+

+{:else}

+

+## ปรับแต่งโมเดลอย่างละเอียดด้วย Keras

+

+โค้ดจริงที่ใช้ Keras จะคล้ายกับเมื่อก่อนมาก การเปลี่ยนแปลงเพียงอย่างเดียวคือวิธีการจัดเรียงข้อมูลเป็นชุดและฟังก์ชันการคำนวณหน่วยเมตริก

+

+{/if}

+

+

+### การจัดเรียงข้อมูล[[การจัดเรียงข้อมูล]]

+

+เราไม่สามารถใช้ `DataCollatorWithPadding` เหมือนใน [บทที่ 3](/course/th/chapter3) ได้ เพราะนั่นเป็นเพียงการแพดอินพุตเท่านั้น (ID อินพุต, attention mask และ ID ประเภทโทเค็น) ในที่นี้ป้ายกำกับของเราควรได้รับการบุในลักษณะเดียวกับอินพุตเพื่อให้มีขนาดเท่ากัน โดยใช้ค่า "-100" เพื่อที่การคาดการณ์ที่เกี่ยวข้องจะถูกละเว้นในการคำนวณการสูญเสีย

+

+ทั้งหมดนี้ทำโดย [`DataCollatorForTokenClassification`](https://huggingface.co/transformers/main_classes/data_collator.html#datacollatorfortokenclassification) เช่นเดียวกับ `DataCollatorWithPadding` จะใช้ `tokenizer` ที่ใช้ในการประมวลผลอินพุตล่วงหน้า:

+

+{#if fw === 'pt'}

+

+```py

+from transformers import DataCollatorForTokenClassification

+

+data_collator = DataCollatorForTokenClassification(tokenizer=tokenizer)

+```

+

+{:else}

+

+```py

+from transformers import DataCollatorForTokenClassification

+

+data_collator = DataCollatorForTokenClassification(

+ tokenizer=tokenizer, return_tensors="tf"

+)

+```

+

+{/if}

+

+เพื่อทดสอบสิ่งนี้กับตัวอย่างบางส่วน เราสามารถเรียกมันในรายการตัวอย่างจากชุดการฝึกโทเค็นของเรา:

+

+```py

+batch = data_collator([tokenized_datasets["train"][i] for i in range(2)])

+batch["labels"]

+```

+

+```python out

+tensor([[-100, 3, 0, 7, 0, 0, 0, 7, 0, 0, 0, -100],

+ [-100, 1, 2, -100, -100, -100, -100, -100, -100, -100, -100, -100]])

+```

+

+ลองเปรียบเทียบสิ่งนี้กับป้ายกำกับสำหรับองค์ประกอบที่หนึ่งและที่สองในชุดข้อมูลของเรา:

+

+```py

+for i in range(2):

+ print(tokenized_datasets["train"][i]["labels"])

+```

+

+```python out

+[-100, 3, 0, 7, 0, 0, 0, 7, 0, 0, 0, -100]

+[-100, 1, 2, -100]

+```

+

+{#if fw === 'pt'}

+

+ดังที่เราเห็น ป้ายกำกับชุดที่สองได้รับการเสริมให้เท่ากับความยาวของป้ายกำกับแรกโดยใช้ "-100"

+

+{:else}

+

+เครื่องมือรวบรวมข้อมูลของเราพร้อมแล้ว! ตอนนี้เรามาใช้เพื่อสร้าง `tf.data.Dataset` ด้วยเมธอด `to_tf_dataset()` คุณยังสามารถใช้ `model.prepare_tf_dataset()` เพื่อทำสิ่งนี้โดยใช้โค้ดสำเร็จรูปน้อยลงเล็กน้อย คุณจะเห็นสิ่งนี้ในส่วนอื่นๆ บางส่วนของบทนี้

+

+```py

+tf_train_dataset = tokenized_datasets["train"].to_tf_dataset(

+ columns=["attention_mask", "input_ids", "labels", "token_type_ids"],

+ collate_fn=data_collator,

+ shuffle=True,

+ batch_size=16,

+)

+

+tf_eval_dataset = tokenized_datasets["validation"].to_tf_dataset(

+ columns=["attention_mask", "input_ids", "labels", "token_type_ids"],

+ collate_fn=data_collator,

+ shuffle=False,

+ batch_size=16,

+)

+```

+

+

+ จุดต่อไป: โมเดลนั่นเอง

+

+{/if}

+

+{#if fw === 'tf'}

+

+### การกำหนดโมเดล[[การกำหนดโมเดล]]

+

+เนื่องจากเรากำลังแก้ไขปัญหาการจำแนกโทเค็น เราจะใช้คลาส `TFAutoModelForTokenClassification` สิ่งสำคัญที่ต้องจำเมื่อกำหนดโมเดลนี้คือการส่งข้อมูลบางอย่างเกี่ยวกับจำนวนป้ายกำกับที่เรามี วิธีที่ง่ายที่สุดในการทำเช่นนี้คือการส่งผ่านตัวเลขนั้นด้วยอาร์กิวเมนต์ `num_labels` แต่หากเราต้องการให้วิดเจ็ตการอนุมานที่ดีทำงานเหมือนกับที่เราเห็นในตอนต้นของส่วนนี้ จะเป็นการดีกว่าถ้าตั้งค่าการโต้ตอบป้ายกำกับที่ถูกต้องแทน

+

+ควรกำหนดโดยพจนานุกรม 2 ฉบับ ได้แก่ `id2label` และ `label2id` ซึ่งมีการจับคู่จาก ID ไปยัง label และในทางกลับกัน:

+

+```py

+id2label = {i: label for i, label in enumerate(label_names)}

+label2id = {v: k for k, v in id2label.items()}

+```

+

+ตอนนี้เราสามารถส่งต่อไปยังเมธอด `TFAutoModelForTokenClassification.from_pretrained()` ได้ และพวกมันจะถูกตั้งค่าในการกำหนดค่าของโมเดล จากนั้นจึงบันทึกและอัปโหลดไปยัง Hub อย่างเหมาะสม:

+

+```py

+from transformers import TFAutoModelForTokenClassification

+

+model = TFAutoModelForTokenClassification.from_pretrained(

+ model_checkpoint,

+ id2label=id2label,

+ label2id=label2id,

+)

+```

+

+เช่นเดียวกับเมื่อเรากำหนด `TFAutoModelForSequenceClassification` ของเราใน [บทที่ 3](/course/th/chapter3) การสร้างแบบจำลองจะออกคำเตือนว่าน้ำหนัก (weight) บางอย่างไม่ได้ถูกใช้ (น้ำหนักจากส่วนหัวของการฝึกล่วงหน้า) และน้ำหนักอื่น ๆ บางส่วนจะถูกเตรียมใช้งานแบบสุ่ม (weight จากส่วนหัวการจัดประเภทโทเค็นใหม่) และโมเดลนี้ควรได้รับการฝึกอบรม เราจะดำเนินการดังกล่าวภายในไม่กี่นาที แต่ก่อนอื่น โปรดตรวจสอบอีกครั้งว่าโมเดลของเรามีจำนวนป้ายกำกับ (label) ที่ถูกต้อง:

+

+```python

+model.config.num_labels

+```

+

+```python out

+9

+```

+

+

+

+⚠️ หากคุณมีโมเดลที่มีจำนวนป้ายกำกับไม่ถูกต้อง คุณจะได้รับข้อผิดพลาดที่ไม่ชัดเจนเมื่อเรียก `model.fit()` ในภายหลัง การแก้ไขข้อบกพร่องนี้อาจสร้างความรำคาญได้ ดังนั้นโปรดตรวจสอบให้แน่ใจว่าคุณมีป้ายกำกับถึงจำนวนที่คาดไว้

+

+

+

+### การปรับแต่งโมเดล[[การปรับแต่งโมเดล]]

+

+ตอนนี้เราพร้อมที่จะฝึกโมเดลของเราแล้ว! เรายังมีงานดูแลบ้านอีกเล็กน้อยที่ต้องทำก่อน: เราควรเข้าสู่ระบบ Hugging Face และกำหนดไฮเปอร์พารามิเตอร์การฝึกอบรมของเรา หากคุณกำลังใช้งานโน้ตบุ๊ก มีฟังก์ชันอำนวยความสะดวกที่จะช่วยคุณในเรื่องนี้:

+

+```python

+from huggingface_hub import notebook_login

+

+notebook_login()

+```

+

+นี่จะแสดงวิดเจ็ตที่คุณสามารถป้อนข้อมูลรับรองการเข้าสู่ระบบ Hugging Face ของคุณได้

+

+หากคุณไม่ได้ทำงานในโน้ตบุ๊ก เพียงพิมพ์บรรทัดต่อไปนี้ในเทอร์มินัลของคุณ:

+

+```bash

+huggingface-cli login

+```

+

+หลังจากเข้าสู่ระบบแล้ว เราก็สามารถเตรียมทุกอย่างที่จำเป็นเพื่อคอมไพล์โมเดลของเราได้ 🤗 Transformers มีฟังก์ชัน `create_optimizer()` ที่สะดวกสบาย ซึ่งจะให้เครื่องมือเพิ่มประสิทธิภาพ `AdamW` แก่คุณพร้อมการตั้งค่าที่เหมาะสมสำหรับการลดน้ำหนักและการลดอัตราการเรียนรู้ ซึ่งทั้งสองอย่างนี้จะช่วยปรับปรุงประสิทธิภาพของโมเดลของคุณเมื่อเทียบกับเครื่องมือเพิ่มประสิทธิภาพ `Adam` ในตัว :

+

+```python

+from transformers import create_optimizer

+import tensorflow as tf

+

+# Train in mixed-precision float16

+# Comment this line out if you're using a GPU that will not benefit from this

+tf.keras.mixed_precision.set_global_policy("mixed_float16")

+

+# The number of training steps is the number of samples in the dataset, divided by the batch size then multiplied

+# by the total number of epochs. Note that the tf_train_dataset here is a batched tf.data.Dataset,

+# not the original Hugging Face Dataset, so its len() is already num_samples // batch_size.

+num_epochs = 3

+num_train_steps = len(tf_train_dataset) * num_epochs

+

+optimizer, schedule = create_optimizer(

+ init_lr=2e-5,

+ num_warmup_steps=0,

+ num_train_steps=num_train_steps,

+ weight_decay_rate=0.01,

+)

+model.compile(optimizer=optimizer)

+```

+

+โปรดทราบว่าเราไม่ได้ระบุอาร์กิวเมนต์ `loss` ให้กับ `compile()` เนื่องจากแบบจำลองสามารถคำนวณการสูญเสียภายในได้จริง หากคุณคอมไพล์โดยไม่มีการสูญเสียและระบุป้ายกำกับของคุณในพจนานุกรมอินพุต (เช่นเดียวกับที่เราทำในชุดข้อมูลของเรา) แบบจำลองจะฝึกโดยใช้การสูญเสียภายในนั้น ซึ่งจะเหมาะสมสำหรับ งานและประเภทโมเดลที่คุณเลือก

+

+ต่อไป เราจะกำหนด `PushToHubCallback` เพื่ออัปโหลดโมเดลของเราไปยัง Hub ในระหว่างการฝึก และปรับโมเดลให้เข้ากับคอลแบ็กนั้น:

+

+```python

+from transformers.keras_callbacks import PushToHubCallback

+

+callback = PushToHubCallback(output_dir="bert-finetuned-ner", tokenizer=tokenizer)

+

+model.fit(

+ tf_train_dataset,

+ validation_data=tf_eval_dataset,

+ callbacks=[callback],

+ epochs=num_epochs,

+)

+```

+

+คุณสามารถระบุชื่อเต็มของพื้นที่เก็บข้อมูลที่คุณต้องการพุชด้วยอาร์กิวเมนต์ `hub_model_id` (โดยเฉพาะ คุณจะต้องใช้อาร์กิวเมนต์นี้เพื่อพุชไปยังองค์กร) ตัวอย่างเช่น เมื่อเราผลักดันโมเดลไปที่ [`huggingface-course` Organization](https://huggingface.co/huggingface-course) เราได้เพิ่ม `hub_model_id="huggingface-course/bert-finetuned-ner"` ตามค่าเริ่มต้น พื้นที่เก็บข้อมูลที่ใช้จะอยู่ในเนมสเปซของคุณและตั้งชื่อตามไดเร็กทอรีเอาต์พุตที่คุณตั้งค่าไว้ เช่น `"cool_huggingface_user/bert-finetuned-ner"`

+

+

+

+💡 หากไดเร็กทอรีเอาต์พุตที่คุณใช้มีอยู่แล้ว จะต้องเป็นโคลนในเครื่องของที่เก็บที่คุณต้องการพุชไป หากไม่เป็นเช่นนั้น คุณจะได้รับข้อผิดพลาดเมื่อเรียก `model.fit()` และจะต้องตั้งชื่อใหม่

+

+

+

+โปรดทราบว่าในขณะที่การฝึกเกิดขึ้น แต่ละครั้งที่มีการบันทึกโมเดล (ที่นี่ ทุก epoch) โมเดลจะถูกอัปโหลดไปยัง Hub ในเบื้องหลัง ด้วยวิธีนี้ คุณจะสามารถกลับมาฝึกต่อในเครื่องอื่นได้หากจำเป็น

+

+ในขั้นตอนนี้ คุณสามารถใช้วิดเจ็ตการอนุมานบน Model Hub เพื่อทดสอบโมเดลของคุณและแบ่งปันกับเพื่อนๆ ของคุณได้ คุณได้ปรับแต่งโมเดลในงานจำแนกโทเค็นสำเร็จแล้ว ขอแสดงความยินดีด้วย! แต่โมเดลของเราดีจริงแค่ไหน? เราควรประเมินตัวชี้วัดบางอย่างต่อ

+

+{/if}

+

+

+### เมตริก[[เมตริก]]

+

+{#if fw === 'pt'}

+

+หากต้องการให้ `Trainer` คำนวณเมตริกทุก epoch เราจะต้องกำหนดฟังก์ชัน `compute_metrics()` ที่จะรับอาร์เรย์ของการคาดคะเนและป้ายกำกับ แล้วส่งคืนพจนานุกรมพร้อมชื่อและค่าเมตริก

+

+เฟรมเวิร์คแบบดั้งเดิมที่ใช้ในการประเมินการทำนายการจัดหมวดหมู่โทเค็นคือ [*seqeval*](https://github.com/chakki-works/seqeval) หากต้องการใช้หน่วยวัดนี้ เราต้องติดตั้งไลบรารี *seqeval* ก่อน:

+

+```py

+!pip install seqeval

+```

+

+จากนั้นเราสามารถโหลดมันผ่านฟังก์ชัน `evaluate.load()` เหมือนที่เราทำใน [บทที่ 3](/course/th/chapter3):

+

+{:else}

+

+เฟรมเวิร์คแบบดั้งเดิมที่ใช้ในการประเมินการทำนายการจัดหมวดหมู่โทเค็นคือ [*seqeval*](https://github.com/chakki-works/seqeval). หากต้องการใช้หน่วยวัดนี้ เราต้องติดตั้งไลบรารี *seqeval* ก่อน:

+

+```py

+!pip install seqeval

+```

+

+จากนั้นเราสามารถโหลดมันผ่านฟังก์ชัน `evaluate.load()` เหมือนที่เราทำใน [บทที่ 3](/course/th/chapter3):

+

+{/if}

+

+```py

+import evaluate

+

+metric = evaluate.load("seqeval")

+```

+

+เมตริกนี้ไม่ทำงานเหมือนความแม่นยำมาตรฐาน โดยจะใช้รายการป้ายกำกับเป็นสตริง ไม่ใช่จำนวนเต็ม ดังนั้นเราจะต้องถอดรหัสการคาดคะเนและป้ายกำกับทั้งหมดก่อนที่จะส่งต่อไปยังเมตริก มาดูกันว่ามันทำงานอย่างไร ขั้นแรก เราจะได้ป้ายกำกับสำหรับตัวอย่างการฝึกอบรมแรกของเรา:

+

+```py

+labels = raw_datasets["train"][0]["ner_tags"]

+labels = [label_names[i] for i in labels]

+labels

+```

+

+```python out

+['B-ORG', 'O', 'B-MISC', 'O', 'O', 'O', 'B-MISC', 'O', 'O']

+```

+

+จากนั้นเราสามารถสร้างการคาดการณ์ปลอมสำหรับสิ่งเหล่านั้นได้โดยเพียงแค่เปลี่ยนค่าที่ดัชนี 2:

+

+```py

+predictions = labels.copy()

+predictions[2] = "O"

+metric.compute(predictions=[predictions], references=[labels])

+```

+

+โปรดทราบว่าเมตริกจะใช้รายการการคาดการณ์ (ไม่ใช่แค่รายการเดียว) และรายการป้ายกำกับ นี่คือผลลัพธ์:

+

+```python out

+{'MISC': {'precision': 1.0, 'recall': 0.5, 'f1': 0.67, 'number': 2},

+ 'ORG': {'precision': 1.0, 'recall': 1.0, 'f1': 1.0, 'number': 1},

+ 'overall_precision': 1.0,

+ 'overall_recall': 0.67,

+ 'overall_f1': 0.8,

+ 'overall_accuracy': 0.89}

+```

+

+{#if fw === 'pt'}

+

+นี่เป็นการส่งข้อมูลกลับมาจำนวนมาก! เราได้รับความแม่นยำ การเรียกคืน (recall) และคะแนน F1 สำหรับแต่ละเอนทิตีที่แยกจากกัน รวมถึงโดยรวมด้วย สำหรับการคำนวณตัวชี้วัดของเรา เราจะเก็บเฉพาะคะแนนโดยรวมเท่านั้น แต่คุณสามารถปรับแต่งฟังก์ชัน `compute_metrics()` เพื่อส่งคืนตัวชี้วัดทั้งหมดที่คุณต้องการรายงาน

+

+ฟังก์ชัน `compute_metrics()` นี้จะนำ argmax ของ logits มาแปลงเป็นการคาดการณ์ (ตามปกติ logits และความน่าจะเป็นอยู่ในลำดับเดียวกัน ดังนั้นเราจึงไม่จำเป็นต้องใช้ softmax) จากนั้นเราจะต้องแปลงทั้งป้ายกำกับและการทำนายจากจำนวนเต็มเป็นสตริง เราจะลบค่าทั้งหมดที่มีป้ายกำกับเป็น `-100` จากนั้นส่งผลลัพธ์ไปยังเมธอด `metric.compute()`:

+

+```py

+import numpy as np

+

+

+def compute_metrics(eval_preds):

+ logits, labels = eval_preds

+ predictions = np.argmax(logits, axis=-1)

+

+ # Remove ignored index (special tokens) and convert to labels

+ true_labels = [[label_names[l] for l in label if l != -100] for label in labels]

+ true_predictions = [

+ [label_names[p] for (p, l) in zip(prediction, label) if l != -100]

+ for prediction, label in zip(predictions, labels)

+ ]

+ all_metrics = metric.compute(predictions=true_predictions, references=true_labels)

+ return {

+ "precision": all_metrics["overall_precision"],

+ "recall": all_metrics["overall_recall"],

+ "f1": all_metrics["overall_f1"],

+ "accuracy": all_metrics["overall_accuracy"],

+ }

+```

+

+เมื่อเสร็จแล้ว เราก็เกือบจะพร้อมที่จะให้คำจำกัดความ `Trainer` ของเราแล้ว เราแค่ต้องการ `model` เพื่อปรับแต่ง!

+

+{:else}

+

+นี่เป็นการส่งข้อมูลกลับมาจำนวนมาก! เราได้รับความแม่นยำ การเรียกคืน (recall) และคะแนน F1 สำหรับแต่ละเอนทิตีที่แยกจากกัน รวมถึงโดยรวมด้วย ทีนี้มาดูว่าจะเกิดอะไรขึ้นถ้าเราลองใช้การทำนายแบบจำลองจริงเพื่อคำนวณคะแนนจริง

+

+TensorFlow ไม่ชอบการเชื่อมโยงการคาดการณ์ของเราเข้าด้วยกัน เนื่องจากมีความยาวลำดับที่แปรผันได้ ซึ่งหมายความว่าเราไม่สามารถใช้ `model.predict()` ได้เพียงอย่างเดียว -- แต่นั่นจะไม่หยุดเรา เราจะรับการคาดการณ์ทีละชุดและนำมาต่อกันเป็นรายการใหญ่ๆ รายการเดียวในระหว่างที่เราดำเนินการ โดยทิ้งโทเค็น `-100` ที่ระบุการมาสก์/การเติม จากนั้นจึงคำนวณเมตริกในรายการที่ตอนท้าย:

+

+```py

+import numpy as np

+

+all_predictions = []

+all_labels = []

+for batch in tf_eval_dataset:

+ logits = model.predict_on_batch(batch)["logits"]

+ labels = batch["labels"]

+ predictions = np.argmax(logits, axis=-1)

+ for prediction, label in zip(predictions, labels):

+ for predicted_idx, label_idx in zip(prediction, label):

+ if label_idx == -100:

+ continue

+ all_predictions.append(label_names[predicted_idx])

+ all_labels.append(label_names[label_idx])

+metric.compute(predictions=[all_predictions], references=[all_labels])

+```

+

+

+```python out

+{'LOC': {'precision': 0.91, 'recall': 0.92, 'f1': 0.91, 'number': 1668},

+ 'MISC': {'precision': 0.70, 'recall': 0.79, 'f1': 0.74, 'number': 702},

+ 'ORG': {'precision': 0.85, 'recall': 0.90, 'f1': 0.88, 'number': 1661},

+ 'PER': {'precision': 0.95, 'recall': 0.95, 'f1': 0.95, 'number': 1617},

+ 'overall_precision': 0.87,

+ 'overall_recall': 0.91,

+ 'overall_f1': 0.89,

+ 'overall_accuracy': 0.97}

+```

+

+โมเดลของคุณเป็นอย่างไรบ้าง เมื่อเทียบกับของเรา? หากคุณมีตัวเลขใกล้เคียงกัน แสดงว่าการฝึกของคุณสำเร็จ!

+

+{/if}

+

+{#if fw === 'pt'}

+

+### การกำหนดโมเดล[[การกำหนดโมเดล]]

+

+เนื่องจากเรากำลังแก้ไขปัญหาการจำแนกโทเค็น เราจะใช้คลาส `AutoModelForTokenClassification` สิ่งสำคัญที่ต้องจำเมื่อกำหนดโมเดลนี้คือการส่งข้อมูลบางอย่างเกี่ยวกับจำนวนป้ายกำกับที่เรามี วิธีที่ง่ายที่สุดในการทำเช่นนี้คือการส่งผ่านตัวเลขนั้นด้วยอาร์กิวเมนต์ `num_labels` แต่หากเราต้องการให้วิดเจ็ตการอนุมานที่ดีทำงานเหมือนกับที่เราเห็นในตอนต้นของส่วนนี้ จะเป็นการดีกว่าถ้าตั้งค่าการโต้ตอบป้ายกำกับที่ถูกต้องแทน

+

+ควรกำหนดโดยพจนานุกรม 2 ฉบับ ได้แก่ `id2label` และ `label2id` ซึ่งมีการแมปจาก ID ไปยัง label และในทางกลับกัน:

+

+```py

+id2label = {i: label for i, label in enumerate(label_names)}

+label2id = {v: k for k, v in id2label.items()}

+```

+

+ตอนนี้เราสามารถส่งต่อไปยังเมธอด `AutoModelForTokenClassification.from_pretrained()` ได้ และพวกมันจะถูกตั้งค่าในการกำหนดค่าของโมเดล จากนั้นจึงบันทึกและอัปโหลดไปยัง Hub อย่างเหมาะสม:

+

+```py

+from transformers import AutoModelForTokenClassification

+

+model = AutoModelForTokenClassification.from_pretrained(

+ model_checkpoint,

+ id2label=id2label,

+ label2id=label2id,

+)

+```

+

+เช่นเดียวกับเมื่อเรากำหนด `AutoModelForSequenceClassification` ของเราใน [บทที่ 3](/course/th/chapter3) การสร้างแบบจำลองจะออกคำเตือนว่าน้ำหนักบางอย่างไม่ได้ถูกใช้ (น้ำหนักจากส่วนหัวของการฝึกล่วงหน้า) และน้ำหนักอื่นๆ บางส่วนจะถูกเตรียมใช้งานแบบสุ่ม (น้ำหนักนั้น จากส่วนหัวการจัดประเภทโทเค็นใหม่) และโมเดลนี้ควรได้รับการฝึกอบรม เราจะดำเนินการดังกล่าวภายในไม่กี่นาที แต่ก่อนอื่น โปรดตรวจสอบอีกครั้งว่าโมเดลของเรามีจำนวนป้ายกำกับที่ถูกต้อง:

+

+```python

+model.config.num_labels

+```

+

+```python out

+9

+```

+

+

+

+⚠️ หากคุณมีโมเดลที่มีจำนวนป้ายกำกับไม่ถูกต้อง คุณจะได้รับข้อผิดพลาดที่ไม่ชัดเจนเมื่อเรียกใช้เมธอด `Trainer.train()` ในภายหลัง (บางอย่างเช่น "CUDA error: device-side assert triggered") นี่คือสาเหตุอันดับหนึ่งของข้อบกพร่องที่ผู้ใช้รายงานเกี่ยวกับข้อผิดพลาดดังกล่าว ดังนั้นโปรดตรวจสอบให้แน่ใจว่าคุณได้ตรวจสอบนี้เพื่อยืนยันว่าคุณมีป้ายกำกับตามจำนวนที่คาดไว้

+

+

+

+### การปรับแต่งโมเดล[[การปรับแต่งโมเดล]]

+

+ตอนนี้เราพร้อมที่จะฝึกโมเดลของเราแล้ว! เราเพียงแค่ต้องทำสองสิ่งสุดท้ายก่อนที่เราจะกำหนด `Trainer` ของเรา: เข้าสู่ระบบ Hugging Face และกำหนดข้อโต้แย้งในการฝึกของเรา หากคุณกำลังใช้งานโน้ตบุ๊ก มีฟังก์ชันอำนวยความสะดวกที่จะช่วยคุณในเรื่องนี้:

+

+```python

+from huggingface_hub import notebook_login

+

+notebook_login()

+```

+

+นี่จะแสดงวิดเจ็ตที่คุณสามารถป้อนข้อมูลรับรองการเข้าสู่ระบบ Hugging Face ของคุณได้

+

+หากคุณไม่ได้ทำงานในโน้ตบุ๊ก เพียงพิมพ์บรรทัดต่อไปนี้ในเทอร์มินัลของคุณ:

+

+```bash

+huggingface-cli login

+```

+

+เมื่อเสร็จแล้ว เราก็สามารถกำหนด `TrainingArguments` ของเราได้:

+

+```python

+from transformers import TrainingArguments

+

+args = TrainingArguments(

+ "bert-finetuned-ner",

+ evaluation_strategy="epoch",

+ save_strategy="epoch",

+ learning_rate=2e-5,

+ num_train_epochs=3,

+ weight_decay=0.01,

+ push_to_hub=True,

+)

+```

+

+คุณเคยเห็นสิ่งเหล่านี้มาแล้วส่วนใหญ่: เราตั้งค่าไฮเปอร์พารามิเตอร์บางอย่าง (เช่น อัตราการเรียนรู้ จำนวน epoch ที่จะฝึก และการลดของน้ำหนัก) และเราระบุ `push_to_hub=True` เพื่อระบุว่าเราต้องการบันทึกโมเดล และประเมินผลในตอนท้ายของทุก epoch และเราต้องการอัปโหลดผลลัพธ์ของเราไปยัง Model Hub โปรดทราบว่าคุณสามารถระบุชื่อของพื้นที่เก็บข้อมูลที่คุณต้องการพุชไปได้ด้วยอาร์กิวเมนต์ `hub_model_id` (โดยเฉพาะ คุณจะต้องใช้อาร์กิวเมนต์นี้เพื่อพุชไปยังองค์กร) ตัวอย่างเช่น เมื่อเราผลักโมเดลไปที่ [`huggingface-course` Organization](https://huggingface.co/huggingface-course) เราได้เพิ่ม `hub_model_id="huggingface-course/bert-finetuned-ner"` ลงใน `TrainingArguments` ตามค่าเริ่มต้น พื้นที่เก็บข้อมูลที่ใช้จะอยู่ในเนมสเปซของคุณและตั้งชื่อตามไดเร็กทอรีเอาต์พุตที่คุณตั้งค่า ดังนั้นในกรณีของเราจะเป็น `"sgugger/bert-finetuned-ner"`

+

+

+

+💡 หากไดเร็กทอรีเอาต์พุตที่คุณใช้มีอยู่แล้ว จะต้องเป็นโคลนในเครื่องของที่เก็บที่คุณต้องการพุชไป หากไม่เป็นเช่นนั้น คุณจะได้รับข้อผิดพลาดเมื่อกำหนด `Trainer` ของคุณและจะต้องตั้งชื่อใหม่

+

+

+

+ในที่สุด เราก็ส่งทุกอย่างให้กับ `Trainer` และเริ่มต้นการฝึกอบรม:

+

+```python

+from transformers import Trainer

+

+trainer = Trainer(

+ model=model,

+ args=args,

+ train_dataset=tokenized_datasets["train"],

+ eval_dataset=tokenized_datasets["validation"],

+ data_collator=data_collator,

+ compute_metrics=compute_metrics,

+ tokenizer=tokenizer,

+)

+trainer.train()

+```

+

+โปรดทราบว่าในขณะที่การฝึกเกิดขึ้น แต่ละครั้งที่มีการบันทึกโมเดล (ที่นี่ ทุก epoch) โมเดลจะถูกอัปโหลดไปยัง Hub ในเบื้องหลัง ด้วยวิธีนี้ คุณจะสามารถกลับมาฝึกต่อในเครื่องอื่นได้หากจำเป็น

+

+เมื่อการฝึกอบรมเสร็จสิ้น เราจะใช้เมธอด `push_to_hub()` เพื่อให้แน่ใจว่าเราจะอัปโหลดโมเดลเวอร์ชันล่าสุด:

+

+```py

+trainer.push_to_hub(commit_message="Training complete")

+```

+

+คำสั่งนี้จะส่งคืน URL ของการคอมมิตที่เพิ่งทำไป หากคุณต้องการตรวจสอบ:

+

+```python out

+'https://huggingface.co/sgugger/bert-finetuned-ner/commit/26ab21e5b1568f9afeccdaed2d8715f571d786ed'

+```

+

+`Trainer` ยังร่างการ์ดโมเดลพร้อมผลการประเมินทั้งหมดแล้วอัปโหลด ในขั้นตอนนี้ คุณสามารถใช้วิดเจ็ตการอนุมานบน Model Hub เพื่อทดสอบโมเดลของคุณและแบ่งปันกับเพื่อนๆ ของคุณได้ คุณได้ปรับแต่งโมเดลในงานจำแนกโทเค็นสำเร็จแล้ว ขอแสดงความยินดีด้วย!

+

+หากคุณต้องการเจาะลึกลงไปในวงจรการฝึกซ้อมอีกสักหน่อย ตอนนี้เราจะแสดงให้คุณเห็นถึงวิธีการทำสิ่งเดียวกันโดยใช้ 🤗 Accelerate

+

+## การกำหนดเทร็นนิ่งลูปเฉพาะ[[การกำหนดเทร็นนิ่งลูปเฉพาะ]]

+

+ตอนนี้เรามาดูวงจรการฝึกซ้อมทั้งหมดกัน เพื่อให้คุณปรับแต่งส่วนต่างๆ ที่ต้องการได้อย่างง่ายดาย มันจะดูเหมือนกับสิ่งที่เราทำใน [บทที่ 3](/course/th/chapter3/4) มาก โดยมีการเปลี่ยนแปลงเล็กน้อยสำหรับการประเมิน

+

+### เตรียมทุกอย่างเพื่อการฝึก[[เตรียมทุกอย่างเพื่อการฝึก]]

+

+ก่อนอื่นเราต้องสร้าง `DataLoader`s จากชุดข้อมูลของเรา เราจะใช้ `data_collator` ของเราซ้ำเป็น `collate_fn` และสับเปลี่ยนชุดการฝึก แต่ไม่ใช่ชุดการตรวจสอบ:

+

+```py

+from torch.utils.data import DataLoader

+

+train_dataloader = DataLoader(

+ tokenized_datasets["train"],

+ shuffle=True,

+ collate_fn=data_collator,

+ batch_size=8,

+)

+eval_dataloader = DataLoader(

+ tokenized_datasets["validation"], collate_fn=data_collator, batch_size=8

+)

+```

+

+ต่อไป เราจะสร้างโมเดลของเราขึ้นมาใหม่ เพื่อให้แน่ใจว่าเราจะไม่ทำการปรับแต่งแบบละเอียดจากเมื่อก่อนต่อไป แต่เริ่มต้นจากโมเดล BERT ที่ได้รับการฝึกไว้ล่วงหน้าอีกครั้ง:

+

+```py

+model = AutoModelForTokenClassification.from_pretrained(

+ model_checkpoint,

+ id2label=id2label,

+ label2id=label2id,

+)

+```

+

+จากนั้นเราจะต้องมีเครื่องมือเพิ่มประสิทธิภาพ เราจะใช้ `AdamW` แบบคลาสสิกซึ่งคล้ายกับ 'Adam` แต่มีการแก้ไขวิธีการลดน้ำหนัก:

+

+```py

+from torch.optim import AdamW

+

+optimizer = AdamW(model.parameters(), lr=2e-5)

+```

+

+เมื่อเรามีอ็อบเจ็กต์ทั้งหมดแล้ว เราก็สามารถส่งมันไปที่เมธอด `accelerator.prepare()` ได้:

+

+```py

+from accelerate import Accelerator

+

+accelerator = Accelerator()

+model, optimizer, train_dataloader, eval_dataloader = accelerator.prepare(

+ model, optimizer, train_dataloader, eval_dataloader

+)

+```

+

+

+

+🚨 หากคุณกำลังฝึกบน TPU คุณจะต้องย้ายโค้ดทั้งหมดที่เริ่มต้นจากเซลล์ด้านบนไปยังฟังก์ชันการฝึกเฉพาะ ดู [บทที่ 3](/course/th/chapter3) สำหรับรายละเอียดเพิ่มเติม

+

+

+

+ตอนนี้เราได้ส่ง `train_dataloader` ไปที่ `accelerator.prepare()` แล้ว เราสามารถใช้ความยาวของมันเพื่อคำนวณจำนวนขั้นตอนการฝึกได้ โปรดจำไว้ว่าเราควรทำเช่นนี้เสมอหลังจากเตรียม dataloader เนื่องจากวิธีการนั้นจะเปลี่ยนความยาวของมัน เราใช้กำหนดการเชิงเส้นแบบคลาสสิกจากอัตราการเรียนรู้ถึง 0:

+

+```py

+from transformers import get_scheduler

+

+num_train_epochs = 3

+num_update_steps_per_epoch = len(train_dataloader)

+num_training_steps = num_train_epochs * num_update_steps_per_epoch

+

+lr_scheduler = get_scheduler(

+ "linear",

+ optimizer=optimizer,

+ num_warmup_steps=0,

+ num_training_steps=num_training_steps,

+)

+```

+

+สุดท้ายนี้ ในการผลักดันโมเดลของเราไปที่ Hub เราจะต้องสร้างออบเจ็กต์ `Repository` ในโฟลเดอร์ที่ใช้งานได้ ขั้นแรกให้เข้าสู่ระบบ Hugging Face หากคุณยังไม่ได้เข้าสู่ระบบ เราจะกำหนดชื่อที่เก็บจาก ID โมเดลที่เราต้องการให้กับโมเดลของเรา (อย่าลังเลที่จะแทนที่ `repo_name` ด้วยตัวเลือกของคุณเอง เพียงต้องมีชื่อผู้ใช้ของคุณ ซึ่งเป็นสิ่งที่ฟังก์ชัน `get_full_repo_name()` ทำ ):

+

+```py

+from huggingface_hub import Repository, get_full_repo_name

+

+model_name = "bert-finetuned-ner-accelerate"

+repo_name = get_full_repo_name(model_name)

+repo_name

+```

+

+```python out

+'sgugger/bert-finetuned-ner-accelerate'

+```

+

+จากนั้นเราสามารถโคลนพื้นที่เก็บข้อมูลนั้นในโฟลเดอร์ในเครื่องได้ หากมีอยู่แล้ว โฟลเดอร์ในเครื่องนี้ควรเป็นโคลนของพื้นที่เก็บข้อมูลที่เรากำลังทำงานด้วย:

+

+```py

+output_dir = "bert-finetuned-ner-accelerate"

+repo = Repository(output_dir, clone_from=repo_name)

+```

+

+ตอนนี้เราสามารถอัปโหลดทุกสิ่งที่เราบันทึกไว้ใน `output_dir` ได้โดยการเรียกเมธอด `repo.push_to_hub()` ซึ่งจะช่วยให้เราอัปโหลดโมเดลระดับกลางในตอนท้ายของแต่ละ epoch ได้

+

+### ลูปการฝึกอบรม[[ลูปการฝึกอบรม]]

+

+ตอนนี้เราพร้อมที่จะเขียนลูปการฝึกอบรม (training loop) ฉบับเต็มแล้ว เพื่อให้ส่วนการประเมินง่ายขึ้น เราได้กำหนดฟังก์ชัน `postprocess()` นี้ ซึ่งใช้การคาดการณ์และป้ายกำกับและแปลงเป็นรายการสตริง เหมือนกับที่วัตถุ `เมตริก` ของเราคาดหวัง:

+

+```py

+def postprocess(predictions, labels):

+ predictions = predictions.detach().cpu().clone().numpy()

+ labels = labels.detach().cpu().clone().numpy()

+

+ # Remove ignored index (special tokens) and convert to labels

+ true_labels = [[label_names[l] for l in label if l != -100] for label in labels]

+ true_predictions = [

+ [label_names[p] for (p, l) in zip(prediction, label) if l != -100]

+ for prediction, label in zip(predictions, labels)

+ ]

+ return true_labels, true_predictions

+```

+

+จากนั้นเราก็สามารถเขียนลูปการฝึกอบรมได้ หลังจากกำหนดแถบความคืบหน้าเพื่อติดตามว่าการฝึกดำเนินไปอย่างไร ลูปจะมีสามส่วน:

+

+- การฝึกในตัวเอง ซึ่งเป็นการวนซ้ำแบบคลาสสิกบน `train_dataloader` คือการส่งต่อผ่านโมเดล จากนั้นย้อนกลับและขั้นตอนการเพิ่มประสิทธิภาพ

+- การประเมิน ซึ่งมีความแปลกใหม่หลังจากได้รับผลลัพธ์ของแบบจำลองของเราเป็นชุด: เนื่องจากกระบวนการสองกระบวนการอาจมีการเสริมอินพุตและป้ายกำกับเป็นรูปร่างที่แตกต่างกัน เราจึงจำเป็นต้องใช้ `accelerator.pad_across_processes()` เพื่อทำการคาดการณ์และ ติดป้ายกำกับรูปร่างเดียวกันก่อนที่จะเรียกเมธอด `gather()` หากเราไม่ทำเช่นนี้ การประเมินจะเกิดข้อผิดพลาดหรือหยุดทำงานตลอดไป จากนั้นเราจะส่งผลลัพธ์ไปที่ `metric.add_batch()` และเรียก `metric.compute()` เมื่อลูปการประเมินสิ้นสุดลง

+- การบันทึกและการอัปโหลด โดยที่เราจะบันทึกโมเดลและโทเค็นไนเซอร์ก่อน จากนั้นจึงเรียก `repo.push_to_hub()` โปรดสังเกตว่าเราใช้อาร์กิวเมนต์ `blocking=False` เพื่อบอกไลบรารี 🤗 Hub ให้พุชในกระบวนการอะซิงโครนัส ด้วยวิธีนี้ การฝึกอบรมจะดำเนินต่อไปตามปกติและคำสั่ง (แบบยาว) นี้จะดำเนินการในเบื้องหลัง

+

+นี่คือโค้ดที่สมบูรณ์สำหรับลูปการฝึกอบรม:

+

+```py

+from tqdm.auto import tqdm

+import torch

+

+progress_bar = tqdm(range(num_training_steps))

+

+for epoch in range(num_train_epochs):

+ # Training

+ model.train()

+ for batch in train_dataloader:

+ outputs = model(**batch)

+ loss = outputs.loss

+ accelerator.backward(loss)

+

+ optimizer.step()

+ lr_scheduler.step()

+ optimizer.zero_grad()

+ progress_bar.update(1)

+

+ # Evaluation

+ model.eval()

+ for batch in eval_dataloader:

+ with torch.no_grad():

+ outputs = model(**batch)

+

+ predictions = outputs.logits.argmax(dim=-1)

+ labels = batch["labels"]

+

+ # Necessary to pad predictions and labels for being gathered

+ predictions = accelerator.pad_across_processes(predictions, dim=1, pad_index=-100)

+ labels = accelerator.pad_across_processes(labels, dim=1, pad_index=-100)

+

+ predictions_gathered = accelerator.gather(predictions)

+ labels_gathered = accelerator.gather(labels)

+

+ true_predictions, true_labels = postprocess(predictions_gathered, labels_gathered)

+ metric.add_batch(predictions=true_predictions, references=true_labels)

+

+ results = metric.compute()

+ print(

+ f"epoch {epoch}:",

+ {

+ key: results[f"overall_{key}"]

+ for key in ["precision", "recall", "f1", "accuracy"]

+ },

+ )

+

+ # Save and upload

+ accelerator.wait_for_everyone()

+ unwrapped_model = accelerator.unwrap_model(model)

+ unwrapped_model.save_pretrained(output_dir, save_function=accelerator.save)

+ if accelerator.is_main_process:

+ tokenizer.save_pretrained(output_dir)

+ repo.push_to_hub(

+ commit_message=f"Training in progress epoch {epoch}", blocking=False

+ )

+```

+

+ในกรณีที่นี่เป็นครั้งแรกที่คุณเห็นโมเดลที่บันทึกไว้ด้วย 🤗 Accelerate ลองใช้เวลาสักครู่เพื่อตรวจสอบโค้ดสามบรรทัดที่มาพร้อมกับโมเดลนั้น:

+

+```py

+accelerator.wait_for_everyone()

+unwrapped_model = accelerator.unwrap_model(model)

+unwrapped_model.save_pretrained(output_dir, save_function=accelerator.save)

+```

+

+บรรทัดแรกอธิบายในตัวมันเอง: มันบอกกระบวนการทั้งหมดให้รอจนกว่าทุกคนจะถึงขั้นตอนนั้นก่อนจะดำเนินการต่อ เพื่อให้แน่ใจว่าเรามีโมเดลเดียวกันในทุกกระบวนการก่อนที่จะบันทึก จากนั้นเราก็คว้า `unwrapped_model` ซึ่งเป็นโมเดลพื้นฐานที่เรากำหนดไว้ เมธอด `accelerator.prepare()` เปลี่ยนโมเดลให้ทำงานในการฝึกแบบกระจาย ดังนั้นจะไม่มีเมธอด `save_pretrained()` อีกต่อไป เมธอด `accelerator.unwrap_model()` จะยกเลิกขั้นตอนนั้น สุดท้ายนี้ เราเรียก `save_pretrained()` แต่บอกวิธีการนั้นให้ใช้ `accelerator.save()` แทน `torch.save()`

+

+เมื่อเสร็จแล้ว คุณควรมีโมเดลที่สร้างผลลัพธ์ที่ค่อนข้างคล้ายกับโมเดลที่ได้รับการฝึกกับ `Trainer` คุณสามารถตรวจสอบโมเดลที่เราฝึกได้โดยใช้โค้ดนี้ที่ [*huggingface-course/bert-finetuned-ner-accelerate*](https://huggingface.co/huggingface-course/bert-finetuned-ner-accelerate) และหากคุณต้องการทดสอบการปรับแต่งใดๆ ในลูปการฝึก คุณสามารถนำไปใช้ได้โดยตรงโดยแก้ไขโค้ดที่แสดงด้านบน!

+

+{/if}

+

+## การใช้โมเดลที่ปรับแต่งแล้ว[[การใช้โมเดลที่ปรับแต่งแล้ว]]

+

+เราได้แสดงให้คุณเห็นแล้วว่าคุณสามารถใช้โมเดลที่เราปรับแต่งอย่างละเอียดบน Model Hub ด้วยวิดเจ็ตการอนุมานได้อย่างไร หากต้องการใช้ภายในเครื่องใน `pipeline` คุณเพียงแค่ต้องระบุตัวระบุโมเดลที่เหมาะสม:

+

+```py

+from transformers import pipeline

+

+# Replace this with your own checkpoint

+model_checkpoint = "huggingface-course/bert-finetuned-ner"

+token_classifier = pipeline(

+ "token-classification", model=model_checkpoint, aggregation_strategy="simple"

+)

+token_classifier("My name is Sylvain and I work at Hugging Face in Brooklyn.")

+```

+

+```python out

+[{'entity_group': 'PER', 'score': 0.9988506, 'word': 'Sylvain', 'start': 11, 'end': 18},

+ {'entity_group': 'ORG', 'score': 0.9647625, 'word': 'Hugging Face', 'start': 33, 'end': 45},

+ {'entity_group': 'LOC', 'score': 0.9986118, 'word': 'Brooklyn', 'start': 49, 'end': 57}]

+```

+

+ยอดเยี่ยม! โมเดลของเราใช้งานได้เช่นเดียวกับโมเดลเริ่มต้นสำหรับไปป์ไลน์นี้

diff --git a/chapters/th/chapter7/3.mdx b/chapters/th/chapter7/3.mdx

new file mode 100644

index 000000000..09f657bfb

--- /dev/null

+++ b/chapters/th/chapter7/3.mdx

@@ -0,0 +1,1045 @@

+

+

+# การปรับแต่งโมเดลภาษา[[การปรับแต่งโมเดลภาษา]]

+

+{#if fw === 'pt'}

+

+

+

+{:else}

+

+

+

+{/if}

+

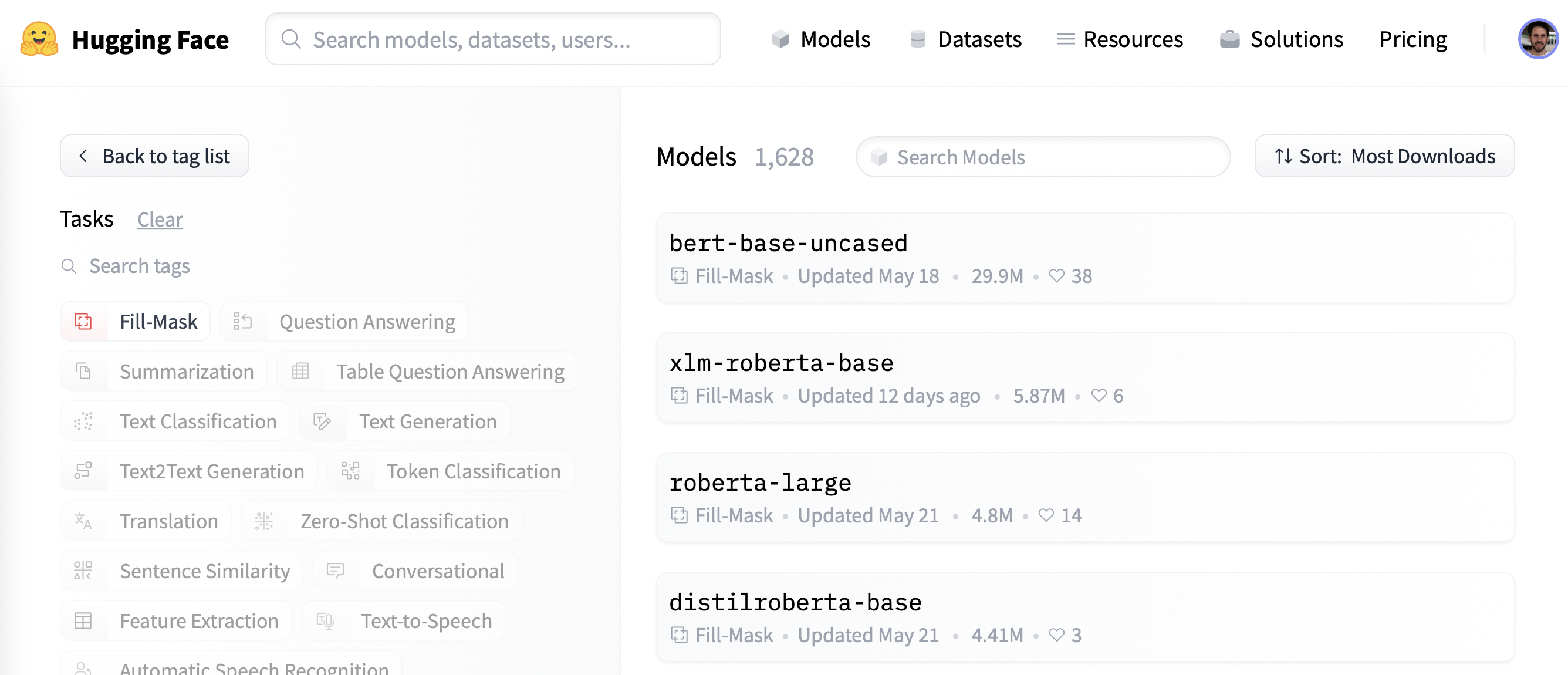

+สำหรับแอปพลิเคชัน NLP จำนวนมากที่เกี่ยวข้องกับโมเดล Transformer คุณสามารถใช้โมเดลที่ได้รับการฝึกล่วงหน้าจาก Hugging Face Hub และปรับแต่งข้อมูลของคุณโดยตรงสำหรับงานที่มีอยู่ โดยมีเงื่อนไขว่าคลังข้อมูลที่ใช้สำหรับการฝึกล่วงหน้า (pretraining) ไม่แตกต่างจากคลังข้อมูลที่ใช้ในการปรับแต่งอย่างละเอียดมากนัก การเรียนรู้แบบถ่ายโอน (transfer learning) มักจะให้ผลลัพธ์ที่ดี

+

+อย่างไรก็ตาม มีบางกรณีที่คุณจะต้องปรับแต่งโมเดลภาษาในข้อมูลของคุณก่อน ก่อนที่จะฝึกหัวหน้างานเฉพาะด้าน ตัวอย่างเช่น หากชุดข้อมูลของคุณมีสัญญาทางกฎหมายหรือบทความทางวิทยาศาสตร์ โมเดล Transformer ธรรมดา เช่น BERT โดยทั่วไปจะถือว่าคำเฉพาะโดเมนในคลังข้อมูลของคุณเป็นโทเค็นที่หายาก และประสิทธิภาพผลลัพธ์ที่ได้อาจน้อยกว่าที่น่าพอใจ ด้วยการปรับแต่งโมเดลภาษาบนข้อมูลในโดเมน คุณจะเพิ่มประสิทธิภาพของงานดาวน์สตรีมหลายๆ งานได้ ซึ่งหมายความว่าโดยปกติคุณจะต้องทำขั้นตอนนี้เพียงครั้งเดียวเท่านั้น!

+

+กระบวนการปรับแต่งโมเดลภาษาที่ได้รับการฝึกล่วงหน้าอย่างละเอียดในข้อมูลในโดเมนนี้มักจะเรียกว่า _domain adaptation_ ได้รับความนิยมในปี 2018 โดย [ULMFiT](https://arxiv.org/abs/1801.06146) ซึ่งเป็นหนึ่งในสถาปัตยกรรมประสาทแรกๆ (อิงจาก LSTM) ที่ทำให้การเรียนรู้แบบถ่ายโอนใช้งานได้จริงสำหรับ NLP ตัวอย่างการปรับโดเมนด้วย ULMFiT แสดงอยู่ในภาพด้านล่าง ในส่วนนี้ เราจะทำสิ่งที่คล้ายกัน แต่ใช้ Transformer แทน LSTM!

+

+

+

+

+คุณค้นหาโมเดลที่เราจะฝึกและอัปโหลดไปยัง Hub และตรวจสอบการคาดการณ์อีกครั้งได้ [ที่นี่](https://huggingface.co/huggingface-course/bert-finetuned-ner?text=My+name+is+Sylvain+and+I+work+at+Hugging+Face+in+Brooklyn).

+

+## การเตรียมข้อมูล[[การเตรียมข้อมูล]]

+

+ก่อนอื่น เราต้องการชุดข้อมูลที่เหมาะสำหรับการจำแนกคำ ในส่วนนี้ เราจะใช้ [CoNLL-2003 dataset](https://huggingface.co/datasets/conll2003) ซึ่งรวบรวมข่าวจาก Reuters

+

+

+

+💡 ตราบใดที่ชุดข้อมูลของคุณประกอบด้วยข้อความที่แบ่งออกเป็นคำโดยมีป้ายกำกับที่เกี่ยวข้อง คุณจะสามารถปรับขั้นตอนการประมวลผลข้อมูลที่อธิบายไว้ที่นี่กับชุดข้อมูลของคุณเองได้ ย้อนกลับไปที่ [บทที่ 5](/course/th/chapter5) หากคุณต้องการทบทวนวิธีโหลดข้อมูลที่คุณกำหนดเองใน `ชุดข้อมูล`

+

+

+

+### The CoNLL-2003 dataset[[the-conll-2003-dataset]]

+

+ในการโหลดชุดข้อมูล CoNLL-2003 เราใช้เมธอด `load_dataset()` จากไลบรารี 🤗 ชุดข้อมูล:

+

+```py

+from datasets import load_dataset

+

+raw_datasets = load_dataset("conll2003")

+```

+

+การดำเนินการนี้จะดาวน์โหลดและแคชชุดข้อมูล ดังที่เราเห็นใน [บทที่ 3](/course/th/chapter3) สำหรับชุดข้อมูล GLUE MRPC การตรวจสอบออบเจ็กต์นี้จะแสดงให้เราเห็นคอลัมน์ที่มีอยู่และการแบ่งระหว่างชุดการฝึก การตรวจสอบ และการทดสอบ:

+

+```py

+raw_datasets

+```

+

+```python out

+DatasetDict({

+ train: Dataset({

+ features: ['chunk_tags', 'id', 'ner_tags', 'pos_tags', 'tokens'],

+ num_rows: 14041

+ })

+ validation: Dataset({

+ features: ['chunk_tags', 'id', 'ner_tags', 'pos_tags', 'tokens'],

+ num_rows: 3250

+ })

+ test: Dataset({

+ features: ['chunk_tags', 'id', 'ner_tags', 'pos_tags', 'tokens'],

+ num_rows: 3453

+ })

+})

+```

+

+โดยเฉพาะอย่างยิ่ง เราจะเห็นว่าชุดข้อมูลมีป้ายกำกับ (label) สำหรับงานสามอย่างที่เรากล่าวถึงก่อนหน้านี้: NER, POS และ chunking จะเห็นว่าความแตกต่างอย่างมากจากชุดข้อมูลอื่นๆ ก็คือข้อความที่ป้อนไม่ได้ถูกนำเสนอเป็นประโยคหรือเอกสาร แต่เป็นรายการของคำ (คอลัมน์สุดท้ายเรียกว่า `โทเค็น` แต่มีคำในแง่ที่ว่าสิ่งเหล่านี้เป็นอินพุตโทเค็นล่วงหน้าที่ยังคงต้องการ เพื่อผ่านโทเค็นไนเซอร์สำหรับโทเค็นคำย่อย)

+

+มาดูองค์ประกอบแรกของชุดการฝึกกันดีกว่า:

+

+```py

+raw_datasets["train"][0]["tokens"]

+```

+

+```python out

+['EU', 'rejects', 'German', 'call', 'to', 'boycott', 'British', 'lamb', '.']

+```

+

+เนื่องจากเราต้องการดำเนินการจดจำเอนทิตีที่มีชื่อ เราจะดูที่แท็ก NER:

+

+```py

+raw_datasets["train"][0]["ner_tags"]

+```

+

+```python out

+[3, 0, 7, 0, 0, 0, 7, 0, 0]

+```

+

+สิ่งเหล่านี้คือป้ายกำกับว่าเป็นจำนวนเต็มพร้อมสำหรับการฝึก แต่ก็ไม่จำเป็นเสมอไปเมื่อเราต้องการตรวจสอบข้อมูล เช่นเดียวกับการจัดหมวดหมู่ข้อความ เราสามารถเข้าถึงความสอดคล้องระหว่างจำนวนเต็มเหล่านั้นกับชื่อป้ายกำกับได้โดยดูที่แอตทริบิวต์ `features` ของชุดข้อมูลของเรา:

+

+```py

+ner_feature = raw_datasets["train"].features["ner_tags"]

+ner_feature

+```

+

+```python out

+Sequence(feature=ClassLabel(num_classes=9, names=['O', 'B-PER', 'I-PER', 'B-ORG', 'I-ORG', 'B-LOC', 'I-LOC', 'B-MISC', 'I-MISC'], names_file=None, id=None), length=-1, id=None)

+```

+

+ดังนั้นคอลัมน์นี้จึงมีองค์ประกอบที่เป็นลำดับของ `ClassLabel`s ประเภทขององค์ประกอบของลำดับอยู่ในแอตทริบิวต์ `feature` ของ `ner_feature` นี้ และเราสามารถเข้าถึงรายชื่อได้โดยดูที่แอตทริบิวต์ `names` ของ `feature` นั้น:

+

+```py

+label_names = ner_feature.feature.names

+label_names

+```

+

+```python out

+['O', 'B-PER', 'I-PER', 'B-ORG', 'I-ORG', 'B-LOC', 'I-LOC', 'B-MISC', 'I-MISC']

+```

+

+เราเห็นป้ายกำกับ (label) เหล่านี้แล้วเมื่อเจาะลึกไปป์ไลน์ `การจำแนกคำ` ใน [บทที่ 6](/course/th/chapter6/3) แต่เพื่อการทบทวนอย่างรวดเร็ว:

+

+- `O` หมายความว่าคำนี้ไม่สอดคล้องกับเอนทิตีใด ๆ

+- `B-PER`/`I-PER` หมายถึงคำที่ตรงกับจุดเริ่มต้นของ หรือ อยู่ภายในเอนทิตี *บุคคล*

+- `B-ORG`/`I-ORG` หมายถึงคำที่ตรงกับจุดเริ่มต้นของ หรือ อยู่ภายในเอนทิตี *องค์กร*

+- `B-LOC`/`I-LOC` หมายถึงคำที่สอดคล้องกับจุดเริ่มต้นของ หรือ อยู่ภายในเอนทิตี *สถานที่*

+- `B-MISC`/`I-MISC` หมายถึงคำที่สอดคล้องกับจุดเริ่มต้นของ หรือ อยู่ภายในเอนทิตี *เบ็ดเตล็ด*

+

+มาดูการถอดรหัสป้ายกำกับที่เราเห็นก่อนหน้านี้ ซึ่งทำให้เราได้สิ่งนี้:

+

+```python

+words = raw_datasets["train"][0]["tokens"]

+labels = raw_datasets["train"][0]["ner_tags"]

+line1 = ""

+line2 = ""

+for word, label in zip(words, labels):

+ full_label = label_names[label]

+ max_length = max(len(word), len(full_label))

+ line1 += word + " " * (max_length - len(word) + 1)

+ line2 += full_label + " " * (max_length - len(full_label) + 1)

+

+print(line1)

+print(line2)

+```

+

+```python out

+'EU rejects German call to boycott British lamb .'

+'B-ORG O B-MISC O O O B-MISC O O'

+```

+

+และสำหรับตัวอย่างการผสมป้ายกำกับ `B-` และ `I-` นี่คือสิ่งที่โค้ดเดียวกันนี้ให้กับองค์ประกอบของชุดการฝึกที่ดัชนี 4:

+

+```python out

+'Germany \'s representative to the European Union \'s veterinary committee Werner Zwingmann said on Wednesday consumers should buy sheepmeat from countries other than Britain until the scientific advice was clearer .'

+'B-LOC O O O O B-ORG I-ORG O O O B-PER I-PER O O O O O O O O O O O B-LOC O O O O O O O'

+```

+

+ดังที่เราเห็น เอนทิตีที่ประกอบด้วยคำสองคำ เช่น "European Union" และ "Werner Zwingmann" จะถูกจัดว่าเป็นป้ายกำกับ `B-` สำหรับคำแรก และป้ายกำกับ 'I-` สำหรับคำที่สอง

+

+

+

+✏️ **ถึงตาคุณแล้ว!** พิมพ์สองประโยคเดียวกันด้วย POS หรือป้ายกำกับแบบแยกส่วน

+

+

+

+### การประมวลผลข้อมูล[[การประมวลผลข้อมูล]]

+

+

+

+ตามปกติ ข้อความของเราต้องแปลงเป็นรหัสโทเค็นก่อนที่โมเดลจะเข้าใจได้ ดังที่เราเห็นใน [บทที่ 6](/course/th/chapter6/) ความแตกต่างที่สำคัญในกรณีของงานการจำแนกโทเค็นก็คือ เรามีอินพุตโทเค็นล่วงหน้า โชคดีที่ tokenizer API สามารถจัดการกับสิ่งนั้นได้อย่างง่ายดาย เราแค่ต้องเตือน `tokenizer` ด้วยแฟล็กพิเศษ

+

+ขั้นแรก เรามาสร้างออบเจ็กต์ `tokenizer` กัน ดังที่เราได้กล่าวไว้ก่อนหน้านี้ เราจะใช้โมเดลที่ได้รับการฝึกล่วงหน้าของ BERT ดังนั้นเราจะเริ่มต้นด้วยการดาวน์โหลดและแคชโทเค็นไนเซอร์ที่เกี่ยวข้อง:

+

+```python

+from transformers import AutoTokenizer

+

+model_checkpoint = "bert-base-cased"

+tokenizer = AutoTokenizer.from_pretrained(model_checkpoint)

+```

+

+คุณสามารถแทนที่ `model_checkpoint` ด้วยโมเดลอื่นใดก็ได้ที่คุณต้องการจาก [Hub](https://huggingface.co/models) หรือด้วยโฟลเดอร์ในเครื่องที่คุณได้บันทึกโมเดลที่ฝึกไว้ล่วงหน้าและ tokenizer. มีข้อจำกัดเพียงอย่างเดียวคือโทเค็นต้องได้รับการสนับสนุนโดยไลบรารี 🤗 Tokenizers ดังนั้นจึงมีเวอร์ชัน "fast" ให้ใช้งาน คุณสามารถดูสถาปัตยกรรมทั้งหมดที่มาพร้อมกับเวอร์ชันที่รวดเร็วได้ใน [ตารางใหญ่นี้](https://huggingface.co/transformers/#supported-frameworks) และเพื่อตรวจสอบว่าวัตถุ `tokenizer` ที่คุณใช้อยู่นั้นเป็นจริง สนับสนุนโดย 🤗 Tokenizers คุณสามารถดูแอตทริบิวต์ `is_fast` ได้:

+

+```py

+tokenizer.is_fast

+```

+

+```python out

+True

+```

+

+หากต้องการโทเค็นอินพุตที่แปลงเป็นโทเค็นล่วงหน้า (a pre-tokenized input) เราสามารถใช้ `tokenizer` ตามปกติและเพียงเพิ่ม `is_split_into_words=True`:

+

+```py

+inputs = tokenizer(raw_datasets["train"][0]["tokens"], is_split_into_words=True)

+inputs.tokens()

+```

+

+```python out

+['[CLS]', 'EU', 'rejects', 'German', 'call', 'to', 'boycott', 'British', 'la', '##mb', '.', '[SEP]']

+```

+

+ดังที่เราเห็น Tokenizer ได้เพิ่มโทเค็นพิเศษที่ใช้โดยโมเดล (`[CLS]` ที่จุดเริ่มต้นและ `[SEP]` ในตอนท้าย) และปล่อยให้คำส่วนใหญ่ไม่ถูกแตะต้อง อย่างไรก็ตาม คำว่า `lamb` ถูกแปลงเป็นคำย่อย 2 คำ คือ `la` และ `##mb` สิ่งนี้ทำให้เกิดความไม่ตรงกันระหว่างอินพุตของเราและป้ายกำกับ: รายการป้ายกำกับมีเพียง 9 องค์ประกอบ ในขณะที่อินพุตของเราตอนนี้มี 12 โทเค็น การบัญชีสำหรับโทเค็นพิเศษเป็นเรื่องง่าย (เรารู้ว่ามันอยู่ที่จุดเริ่มต้นและจุดสิ้นสุด) แต่เรายังต้องตรวจสอบให้แน่ใจด้วยว่าเราจัดตำแหน่งป้ายกำกับทั้งหมดด้วยคำที่เหมาะสม

+

+โชคดีมาก เนื่องจากเราใช้ tokenizer ที่รวดเร็ว เราจึงสามารถเข้าถึง 🤗 Tokenizers มหาอำนาจได้ ซึ่งหมายความว่าเราสามารถจับคู่โทเค็นแต่ละโทเค็นกับคำที่เกี่ยวข้องได้อย่างง่ายดาย (ดังที่เห็นใน [บทที่ 6](/course/th/chapter6/3)):

+

+```py

+inputs.word_ids()

+```

+

+```python out

+[None, 0, 1, 2, 3, 4, 5, 6, 7, 7, 8, None]

+```

+

+ด้วยการทำงานเพียงเล็กน้อย เราก็สามารถขยายรายการป้ายกำกับของเราให้ตรงกับโทเค็นได้ กฎข้อแรกที่เราจะใช้คือโทเค็นพิเศษจะมีป้ายกำกับ `-100` เนื่องจากโดยค่าเริ่มต้น `-100` คือดัชนีที่ถูกละเว้นในฟังก์ชันการสูญเสีย (loss function) ที่เราจะใช้ (cross entropy) จากนั้น แต่ละโทเค็นจะมีป้ายกำกับเดียวกันกับโทเค็นที่ขึ้นต้นด้วยคำว่าอยู่ข้างใน เนื่องจากเป็นส่วนหนึ่งของเอนทิตีเดียวกัน สำหรับโทเค็นที่อยู่ในคำ แต่ไม่ใช่ที่จุดเริ่มต้น เราจะแทนที่ `B-` ด้วย `I-` (เนื่องจากโทเค็นไม่ได้ขึ้นต้นเอนทิตี):

+

+```python

+def align_labels_with_tokens(labels, word_ids):

+ new_labels = []

+ current_word = None

+ for word_id in word_ids:

+ if word_id != current_word:

+ # Start of a new word!

+ current_word = word_id

+ label = -100 if word_id is None else labels[word_id]

+ new_labels.append(label)

+ elif word_id is None:

+ # Special token

+ new_labels.append(-100)

+ else:

+ # Same word as previous token

+ label = labels[word_id]

+ # If the label is B-XXX we change it to I-XXX

+ if label % 2 == 1:

+ label += 1

+ new_labels.append(label)

+

+ return new_labels

+```

+

+เรามาลองใช้ประโยคแรกกันดีกว่า:

+

+```py

+labels = raw_datasets["train"][0]["ner_tags"]

+word_ids = inputs.word_ids()

+print(labels)

+print(align_labels_with_tokens(labels, word_ids))

+```

+

+```python out

+[3, 0, 7, 0, 0, 0, 7, 0, 0]

+[-100, 3, 0, 7, 0, 0, 0, 7, 0, 0, 0, -100]

+```

+

+ดังที่เราเห็น ฟังก์ชั่นของเราเพิ่ม `-100` สำหรับโทเค็นพิเศษสองตัวที่จุดเริ่มต้นและจุดสิ้นสุด และ `0` ใหม่สำหรับคำของเราที่แบ่งออกเป็นสองโทเค็น

+

+

+

+✏️ **ถึงตาคุณทดลองแล้ว!** นักวิจัยบางคนชอบที่จะระบุป้ายกำกับเพียง 1 ป้ายต่อคำ และกำหนด `-100` ให้กับโทเค็นย่อยอื่นๆ ในคำที่กำหนด นี่คือการหลีกเลี่ยงคำยาวๆ ที่แบ่งออกเป็นโทเค็นย่อยจำนวนมากซึ่งมีส่วนทำให้เกิดการสูญเสียอย่างมาก เปลี่ยนฟังก์ชันก่อนหน้าเพื่อจัดแนวป้ายกำกับกับ ID อินพุตโดยปฏิบัติตามกฎนี้

+

+

+

+ในการประมวลผลชุดข้อมูลทั้งหมดของเราล่วงหน้า เราจำเป็นต้องแปลงโทเค็นอินพุตทั้งหมดและใช้ `align_labels_with_tokens()` กับป้ายกำกับทั้งหมด เพื่อใช้ประโยชน์จากความเร็วของโทเค็นเซอร์ที่รวดเร็วของเรา วิธีที่ดีที่สุดคือโทเค็นข้อความจำนวนมากในเวลาเดียวกัน ดังนั้นเราจะเขียนฟังก์ชันที่ประมวลผลรายการตัวอย่างและใช้เมธอด `Dataset.map()` พร้อมตัวเลือก `batched=True` สิ่งเดียวที่แตกต่างจากตัวอย่างก่อนหน้านี้คือฟังก์ชัน `word_ids()` จำเป็นต้องได้รับดัชนีของตัวอย่างที่เราต้องการ ID คำเมื่ออินพุตไปยังโทเค็นไนเซอร์เป็นรายการข้อความ (หรือในกรณีของเรา รายการ ของรายการคำศัพท์) เราก็เลยเพิ่มเข้าไปด้วย:

+

+```py

+def tokenize_and_align_labels(examples):

+ tokenized_inputs = tokenizer(

+ examples["tokens"], truncation=True, is_split_into_words=True

+ )

+ all_labels = examples["ner_tags"]

+ new_labels = []

+ for i, labels in enumerate(all_labels):

+ word_ids = tokenized_inputs.word_ids(i)

+ new_labels.append(align_labels_with_tokens(labels, word_ids))

+

+ tokenized_inputs["labels"] = new_labels

+ return tokenized_inputs

+```

+

+โปรดทราบว่าเรายังไม่ได้เพิ่มอินพุตของเรา เราจะดำเนินการดังกล่าวในภายหลัง เมื่อสร้างแบทช์ด้วยตัวรวบรวมข้อมูล

+

+ตอนนี้เราสามารถใช้การประมวลผลล่วงหน้าทั้งหมดนั้นในคราวเดียวกับการแยกชุดข้อมูลอื่นๆ ของเรา:

+

+```py

+tokenized_datasets = raw_datasets.map(

+ tokenize_and_align_labels,

+ batched=True,

+ remove_columns=raw_datasets["train"].column_names,

+)

+```

+

+เราได้ทำส่วนที่ยากที่สุดแล้ว! เมื่อข้อมูลได้รับการประมวลผลล่วงหน้าแล้ว การฝึกอบรมจริงจะมีลักษณะเหมือนกับที่เราทำใน [บทที่ 3](/course/th/chapter3) มาก

+

+{#if fw === 'pt'}

+

+## ปรับแต่งโมเดลอย่างละเอียดด้วย `Trainer` API

+

+โค้ดจริงที่ใช้ `Trainer` จะเหมือนกับเมื่อก่อน การเปลี่ยนแปลงเพียงอย่างเดียวคือวิธีการจัดเรียงข้อมูลเป็นชุดและฟังก์ชันการคำนวณหน่วยเมตริก

+

+{:else}

+

+## ปรับแต่งโมเดลอย่างละเอียดด้วย Keras

+

+โค้ดจริงที่ใช้ Keras จะคล้ายกับเมื่อก่อนมาก การเปลี่ยนแปลงเพียงอย่างเดียวคือวิธีการจัดเรียงข้อมูลเป็นชุดและฟังก์ชันการคำนวณหน่วยเมตริก

+

+{/if}

+

+

+### การจัดเรียงข้อมูล[[การจัดเรียงข้อมูล]]

+

+เราไม่สามารถใช้ `DataCollatorWithPadding` เหมือนใน [บทที่ 3](/course/th/chapter3) ได้ เพราะนั่นเป็นเพียงการแพดอินพุตเท่านั้น (ID อินพุต, attention mask และ ID ประเภทโทเค็น) ในที่นี้ป้ายกำกับของเราควรได้รับการบุในลักษณะเดียวกับอินพุตเพื่อให้มีขนาดเท่ากัน โดยใช้ค่า "-100" เพื่อที่การคาดการณ์ที่เกี่ยวข้องจะถูกละเว้นในการคำนวณการสูญเสีย

+

+ทั้งหมดนี้ทำโดย [`DataCollatorForTokenClassification`](https://huggingface.co/transformers/main_classes/data_collator.html#datacollatorfortokenclassification) เช่นเดียวกับ `DataCollatorWithPadding` จะใช้ `tokenizer` ที่ใช้ในการประมวลผลอินพุตล่วงหน้า:

+

+{#if fw === 'pt'}

+

+```py

+from transformers import DataCollatorForTokenClassification

+

+data_collator = DataCollatorForTokenClassification(tokenizer=tokenizer)

+```

+

+{:else}

+

+```py

+from transformers import DataCollatorForTokenClassification

+

+data_collator = DataCollatorForTokenClassification(

+ tokenizer=tokenizer, return_tensors="tf"

+)

+```

+

+{/if}

+

+เพื่อทดสอบสิ่งนี้กับตัวอย่างบางส่วน เราสามารถเรียกมันในรายการตัวอย่างจากชุดการฝึกโทเค็นของเรา:

+

+```py

+batch = data_collator([tokenized_datasets["train"][i] for i in range(2)])

+batch["labels"]

+```

+

+```python out

+tensor([[-100, 3, 0, 7, 0, 0, 0, 7, 0, 0, 0, -100],

+ [-100, 1, 2, -100, -100, -100, -100, -100, -100, -100, -100, -100]])

+```

+

+ลองเปรียบเทียบสิ่งนี้กับป้ายกำกับสำหรับองค์ประกอบที่หนึ่งและที่สองในชุดข้อมูลของเรา:

+

+```py

+for i in range(2):

+ print(tokenized_datasets["train"][i]["labels"])

+```

+

+```python out

+[-100, 3, 0, 7, 0, 0, 0, 7, 0, 0, 0, -100]

+[-100, 1, 2, -100]

+```

+

+{#if fw === 'pt'}

+

+ดังที่เราเห็น ป้ายกำกับชุดที่สองได้รับการเสริมให้เท่ากับความยาวของป้ายกำกับแรกโดยใช้ "-100"

+

+{:else}

+

+เครื่องมือรวบรวมข้อมูลของเราพร้อมแล้ว! ตอนนี้เรามาใช้เพื่อสร้าง `tf.data.Dataset` ด้วยเมธอด `to_tf_dataset()` คุณยังสามารถใช้ `model.prepare_tf_dataset()` เพื่อทำสิ่งนี้โดยใช้โค้ดสำเร็จรูปน้อยลงเล็กน้อย คุณจะเห็นสิ่งนี้ในส่วนอื่นๆ บางส่วนของบทนี้

+

+```py

+tf_train_dataset = tokenized_datasets["train"].to_tf_dataset(

+ columns=["attention_mask", "input_ids", "labels", "token_type_ids"],

+ collate_fn=data_collator,

+ shuffle=True,

+ batch_size=16,

+)

+

+tf_eval_dataset = tokenized_datasets["validation"].to_tf_dataset(

+ columns=["attention_mask", "input_ids", "labels", "token_type_ids"],

+ collate_fn=data_collator,

+ shuffle=False,

+ batch_size=16,

+)

+```

+

+

+ จุดต่อไป: โมเดลนั่นเอง

+

+{/if}

+

+{#if fw === 'tf'}

+

+### การกำหนดโมเดล[[การกำหนดโมเดล]]

+

+เนื่องจากเรากำลังแก้ไขปัญหาการจำแนกโทเค็น เราจะใช้คลาส `TFAutoModelForTokenClassification` สิ่งสำคัญที่ต้องจำเมื่อกำหนดโมเดลนี้คือการส่งข้อมูลบางอย่างเกี่ยวกับจำนวนป้ายกำกับที่เรามี วิธีที่ง่ายที่สุดในการทำเช่นนี้คือการส่งผ่านตัวเลขนั้นด้วยอาร์กิวเมนต์ `num_labels` แต่หากเราต้องการให้วิดเจ็ตการอนุมานที่ดีทำงานเหมือนกับที่เราเห็นในตอนต้นของส่วนนี้ จะเป็นการดีกว่าถ้าตั้งค่าการโต้ตอบป้ายกำกับที่ถูกต้องแทน

+

+ควรกำหนดโดยพจนานุกรม 2 ฉบับ ได้แก่ `id2label` และ `label2id` ซึ่งมีการจับคู่จาก ID ไปยัง label และในทางกลับกัน:

+

+```py

+id2label = {i: label for i, label in enumerate(label_names)}

+label2id = {v: k for k, v in id2label.items()}

+```

+

+ตอนนี้เราสามารถส่งต่อไปยังเมธอด `TFAutoModelForTokenClassification.from_pretrained()` ได้ และพวกมันจะถูกตั้งค่าในการกำหนดค่าของโมเดล จากนั้นจึงบันทึกและอัปโหลดไปยัง Hub อย่างเหมาะสม:

+

+```py

+from transformers import TFAutoModelForTokenClassification

+

+model = TFAutoModelForTokenClassification.from_pretrained(

+ model_checkpoint,

+ id2label=id2label,

+ label2id=label2id,

+)

+```

+

+เช่นเดียวกับเมื่อเรากำหนด `TFAutoModelForSequenceClassification` ของเราใน [บทที่ 3](/course/th/chapter3) การสร้างแบบจำลองจะออกคำเตือนว่าน้ำหนัก (weight) บางอย่างไม่ได้ถูกใช้ (น้ำหนักจากส่วนหัวของการฝึกล่วงหน้า) และน้ำหนักอื่น ๆ บางส่วนจะถูกเตรียมใช้งานแบบสุ่ม (weight จากส่วนหัวการจัดประเภทโทเค็นใหม่) และโมเดลนี้ควรได้รับการฝึกอบรม เราจะดำเนินการดังกล่าวภายในไม่กี่นาที แต่ก่อนอื่น โปรดตรวจสอบอีกครั้งว่าโมเดลของเรามีจำนวนป้ายกำกับ (label) ที่ถูกต้อง:

+

+```python

+model.config.num_labels

+```

+

+```python out

+9

+```

+

+

+

+⚠️ หากคุณมีโมเดลที่มีจำนวนป้ายกำกับไม่ถูกต้อง คุณจะได้รับข้อผิดพลาดที่ไม่ชัดเจนเมื่อเรียก `model.fit()` ในภายหลัง การแก้ไขข้อบกพร่องนี้อาจสร้างความรำคาญได้ ดังนั้นโปรดตรวจสอบให้แน่ใจว่าคุณมีป้ายกำกับถึงจำนวนที่คาดไว้

+

+

+

+### การปรับแต่งโมเดล[[การปรับแต่งโมเดล]]

+

+ตอนนี้เราพร้อมที่จะฝึกโมเดลของเราแล้ว! เรายังมีงานดูแลบ้านอีกเล็กน้อยที่ต้องทำก่อน: เราควรเข้าสู่ระบบ Hugging Face และกำหนดไฮเปอร์พารามิเตอร์การฝึกอบรมของเรา หากคุณกำลังใช้งานโน้ตบุ๊ก มีฟังก์ชันอำนวยความสะดวกที่จะช่วยคุณในเรื่องนี้:

+

+```python

+from huggingface_hub import notebook_login

+

+notebook_login()

+```

+

+นี่จะแสดงวิดเจ็ตที่คุณสามารถป้อนข้อมูลรับรองการเข้าสู่ระบบ Hugging Face ของคุณได้

+

+หากคุณไม่ได้ทำงานในโน้ตบุ๊ก เพียงพิมพ์บรรทัดต่อไปนี้ในเทอร์มินัลของคุณ:

+

+```bash

+huggingface-cli login

+```

+

+หลังจากเข้าสู่ระบบแล้ว เราก็สามารถเตรียมทุกอย่างที่จำเป็นเพื่อคอมไพล์โมเดลของเราได้ 🤗 Transformers มีฟังก์ชัน `create_optimizer()` ที่สะดวกสบาย ซึ่งจะให้เครื่องมือเพิ่มประสิทธิภาพ `AdamW` แก่คุณพร้อมการตั้งค่าที่เหมาะสมสำหรับการลดน้ำหนักและการลดอัตราการเรียนรู้ ซึ่งทั้งสองอย่างนี้จะช่วยปรับปรุงประสิทธิภาพของโมเดลของคุณเมื่อเทียบกับเครื่องมือเพิ่มประสิทธิภาพ `Adam` ในตัว :

+

+```python

+from transformers import create_optimizer

+import tensorflow as tf

+

+# Train in mixed-precision float16

+# Comment this line out if you're using a GPU that will not benefit from this

+tf.keras.mixed_precision.set_global_policy("mixed_float16")

+

+# The number of training steps is the number of samples in the dataset, divided by the batch size then multiplied

+# by the total number of epochs. Note that the tf_train_dataset here is a batched tf.data.Dataset,

+# not the original Hugging Face Dataset, so its len() is already num_samples // batch_size.

+num_epochs = 3

+num_train_steps = len(tf_train_dataset) * num_epochs

+

+optimizer, schedule = create_optimizer(

+ init_lr=2e-5,

+ num_warmup_steps=0,

+ num_train_steps=num_train_steps,

+ weight_decay_rate=0.01,

+)

+model.compile(optimizer=optimizer)

+```

+

+โปรดทราบว่าเราไม่ได้ระบุอาร์กิวเมนต์ `loss` ให้กับ `compile()` เนื่องจากแบบจำลองสามารถคำนวณการสูญเสียภายในได้จริง หากคุณคอมไพล์โดยไม่มีการสูญเสียและระบุป้ายกำกับของคุณในพจนานุกรมอินพุต (เช่นเดียวกับที่เราทำในชุดข้อมูลของเรา) แบบจำลองจะฝึกโดยใช้การสูญเสียภายในนั้น ซึ่งจะเหมาะสมสำหรับ งานและประเภทโมเดลที่คุณเลือก

+

+ต่อไป เราจะกำหนด `PushToHubCallback` เพื่ออัปโหลดโมเดลของเราไปยัง Hub ในระหว่างการฝึก และปรับโมเดลให้เข้ากับคอลแบ็กนั้น:

+

+```python

+from transformers.keras_callbacks import PushToHubCallback

+

+callback = PushToHubCallback(output_dir="bert-finetuned-ner", tokenizer=tokenizer)

+

+model.fit(

+ tf_train_dataset,

+ validation_data=tf_eval_dataset,

+ callbacks=[callback],

+ epochs=num_epochs,

+)

+```

+

+คุณสามารถระบุชื่อเต็มของพื้นที่เก็บข้อมูลที่คุณต้องการพุชด้วยอาร์กิวเมนต์ `hub_model_id` (โดยเฉพาะ คุณจะต้องใช้อาร์กิวเมนต์นี้เพื่อพุชไปยังองค์กร) ตัวอย่างเช่น เมื่อเราผลักดันโมเดลไปที่ [`huggingface-course` Organization](https://huggingface.co/huggingface-course) เราได้เพิ่ม `hub_model_id="huggingface-course/bert-finetuned-ner"` ตามค่าเริ่มต้น พื้นที่เก็บข้อมูลที่ใช้จะอยู่ในเนมสเปซของคุณและตั้งชื่อตามไดเร็กทอรีเอาต์พุตที่คุณตั้งค่าไว้ เช่น `"cool_huggingface_user/bert-finetuned-ner"`

+

+

+

+💡 หากไดเร็กทอรีเอาต์พุตที่คุณใช้มีอยู่แล้ว จะต้องเป็นโคลนในเครื่องของที่เก็บที่คุณต้องการพุชไป หากไม่เป็นเช่นนั้น คุณจะได้รับข้อผิดพลาดเมื่อเรียก `model.fit()` และจะต้องตั้งชื่อใหม่

+

+

+

+โปรดทราบว่าในขณะที่การฝึกเกิดขึ้น แต่ละครั้งที่มีการบันทึกโมเดล (ที่นี่ ทุก epoch) โมเดลจะถูกอัปโหลดไปยัง Hub ในเบื้องหลัง ด้วยวิธีนี้ คุณจะสามารถกลับมาฝึกต่อในเครื่องอื่นได้หากจำเป็น

+

+ในขั้นตอนนี้ คุณสามารถใช้วิดเจ็ตการอนุมานบน Model Hub เพื่อทดสอบโมเดลของคุณและแบ่งปันกับเพื่อนๆ ของคุณได้ คุณได้ปรับแต่งโมเดลในงานจำแนกโทเค็นสำเร็จแล้ว ขอแสดงความยินดีด้วย! แต่โมเดลของเราดีจริงแค่ไหน? เราควรประเมินตัวชี้วัดบางอย่างต่อ

+

+{/if}

+

+

+### เมตริก[[เมตริก]]

+

+{#if fw === 'pt'}

+

+หากต้องการให้ `Trainer` คำนวณเมตริกทุก epoch เราจะต้องกำหนดฟังก์ชัน `compute_metrics()` ที่จะรับอาร์เรย์ของการคาดคะเนและป้ายกำกับ แล้วส่งคืนพจนานุกรมพร้อมชื่อและค่าเมตริก

+

+เฟรมเวิร์คแบบดั้งเดิมที่ใช้ในการประเมินการทำนายการจัดหมวดหมู่โทเค็นคือ [*seqeval*](https://github.com/chakki-works/seqeval) หากต้องการใช้หน่วยวัดนี้ เราต้องติดตั้งไลบรารี *seqeval* ก่อน:

+

+```py

+!pip install seqeval

+```

+

+จากนั้นเราสามารถโหลดมันผ่านฟังก์ชัน `evaluate.load()` เหมือนที่เราทำใน [บทที่ 3](/course/th/chapter3):

+

+{:else}

+

+เฟรมเวิร์คแบบดั้งเดิมที่ใช้ในการประเมินการทำนายการจัดหมวดหมู่โทเค็นคือ [*seqeval*](https://github.com/chakki-works/seqeval). หากต้องการใช้หน่วยวัดนี้ เราต้องติดตั้งไลบรารี *seqeval* ก่อน:

+

+```py

+!pip install seqeval

+```

+

+จากนั้นเราสามารถโหลดมันผ่านฟังก์ชัน `evaluate.load()` เหมือนที่เราทำใน [บทที่ 3](/course/th/chapter3):

+

+{/if}

+

+```py

+import evaluate

+

+metric = evaluate.load("seqeval")

+```

+

+เมตริกนี้ไม่ทำงานเหมือนความแม่นยำมาตรฐาน โดยจะใช้รายการป้ายกำกับเป็นสตริง ไม่ใช่จำนวนเต็ม ดังนั้นเราจะต้องถอดรหัสการคาดคะเนและป้ายกำกับทั้งหมดก่อนที่จะส่งต่อไปยังเมตริก มาดูกันว่ามันทำงานอย่างไร ขั้นแรก เราจะได้ป้ายกำกับสำหรับตัวอย่างการฝึกอบรมแรกของเรา:

+

+```py

+labels = raw_datasets["train"][0]["ner_tags"]

+labels = [label_names[i] for i in labels]

+labels

+```

+

+```python out

+['B-ORG', 'O', 'B-MISC', 'O', 'O', 'O', 'B-MISC', 'O', 'O']

+```

+

+จากนั้นเราสามารถสร้างการคาดการณ์ปลอมสำหรับสิ่งเหล่านั้นได้โดยเพียงแค่เปลี่ยนค่าที่ดัชนี 2:

+

+```py

+predictions = labels.copy()

+predictions[2] = "O"

+metric.compute(predictions=[predictions], references=[labels])

+```

+

+โปรดทราบว่าเมตริกจะใช้รายการการคาดการณ์ (ไม่ใช่แค่รายการเดียว) และรายการป้ายกำกับ นี่คือผลลัพธ์:

+

+```python out

+{'MISC': {'precision': 1.0, 'recall': 0.5, 'f1': 0.67, 'number': 2},

+ 'ORG': {'precision': 1.0, 'recall': 1.0, 'f1': 1.0, 'number': 1},

+ 'overall_precision': 1.0,

+ 'overall_recall': 0.67,

+ 'overall_f1': 0.8,

+ 'overall_accuracy': 0.89}

+```

+

+{#if fw === 'pt'}

+

+นี่เป็นการส่งข้อมูลกลับมาจำนวนมาก! เราได้รับความแม่นยำ การเรียกคืน (recall) และคะแนน F1 สำหรับแต่ละเอนทิตีที่แยกจากกัน รวมถึงโดยรวมด้วย สำหรับการคำนวณตัวชี้วัดของเรา เราจะเก็บเฉพาะคะแนนโดยรวมเท่านั้น แต่คุณสามารถปรับแต่งฟังก์ชัน `compute_metrics()` เพื่อส่งคืนตัวชี้วัดทั้งหมดที่คุณต้องการรายงาน

+

+ฟังก์ชัน `compute_metrics()` นี้จะนำ argmax ของ logits มาแปลงเป็นการคาดการณ์ (ตามปกติ logits และความน่าจะเป็นอยู่ในลำดับเดียวกัน ดังนั้นเราจึงไม่จำเป็นต้องใช้ softmax) จากนั้นเราจะต้องแปลงทั้งป้ายกำกับและการทำนายจากจำนวนเต็มเป็นสตริง เราจะลบค่าทั้งหมดที่มีป้ายกำกับเป็น `-100` จากนั้นส่งผลลัพธ์ไปยังเมธอด `metric.compute()`:

+

+```py

+import numpy as np

+

+

+def compute_metrics(eval_preds):

+ logits, labels = eval_preds

+ predictions = np.argmax(logits, axis=-1)

+

+ # Remove ignored index (special tokens) and convert to labels

+ true_labels = [[label_names[l] for l in label if l != -100] for label in labels]

+ true_predictions = [

+ [label_names[p] for (p, l) in zip(prediction, label) if l != -100]

+ for prediction, label in zip(predictions, labels)

+ ]

+ all_metrics = metric.compute(predictions=true_predictions, references=true_labels)

+ return {

+ "precision": all_metrics["overall_precision"],

+ "recall": all_metrics["overall_recall"],

+ "f1": all_metrics["overall_f1"],

+ "accuracy": all_metrics["overall_accuracy"],

+ }

+```

+

+เมื่อเสร็จแล้ว เราก็เกือบจะพร้อมที่จะให้คำจำกัดความ `Trainer` ของเราแล้ว เราแค่ต้องการ `model` เพื่อปรับแต่ง!

+

+{:else}

+

+นี่เป็นการส่งข้อมูลกลับมาจำนวนมาก! เราได้รับความแม่นยำ การเรียกคืน (recall) และคะแนน F1 สำหรับแต่ละเอนทิตีที่แยกจากกัน รวมถึงโดยรวมด้วย ทีนี้มาดูว่าจะเกิดอะไรขึ้นถ้าเราลองใช้การทำนายแบบจำลองจริงเพื่อคำนวณคะแนนจริง

+

+TensorFlow ไม่ชอบการเชื่อมโยงการคาดการณ์ของเราเข้าด้วยกัน เนื่องจากมีความยาวลำดับที่แปรผันได้ ซึ่งหมายความว่าเราไม่สามารถใช้ `model.predict()` ได้เพียงอย่างเดียว -- แต่นั่นจะไม่หยุดเรา เราจะรับการคาดการณ์ทีละชุดและนำมาต่อกันเป็นรายการใหญ่ๆ รายการเดียวในระหว่างที่เราดำเนินการ โดยทิ้งโทเค็น `-100` ที่ระบุการมาสก์/การเติม จากนั้นจึงคำนวณเมตริกในรายการที่ตอนท้าย:

+

+```py

+import numpy as np

+

+all_predictions = []

+all_labels = []

+for batch in tf_eval_dataset:

+ logits = model.predict_on_batch(batch)["logits"]

+ labels = batch["labels"]

+ predictions = np.argmax(logits, axis=-1)

+ for prediction, label in zip(predictions, labels):

+ for predicted_idx, label_idx in zip(prediction, label):

+ if label_idx == -100:

+ continue

+ all_predictions.append(label_names[predicted_idx])

+ all_labels.append(label_names[label_idx])

+metric.compute(predictions=[all_predictions], references=[all_labels])

+```

+

+

+```python out

+{'LOC': {'precision': 0.91, 'recall': 0.92, 'f1': 0.91, 'number': 1668},

+ 'MISC': {'precision': 0.70, 'recall': 0.79, 'f1': 0.74, 'number': 702},

+ 'ORG': {'precision': 0.85, 'recall': 0.90, 'f1': 0.88, 'number': 1661},

+ 'PER': {'precision': 0.95, 'recall': 0.95, 'f1': 0.95, 'number': 1617},

+ 'overall_precision': 0.87,

+ 'overall_recall': 0.91,

+ 'overall_f1': 0.89,

+ 'overall_accuracy': 0.97}

+```

+

+โมเดลของคุณเป็นอย่างไรบ้าง เมื่อเทียบกับของเรา? หากคุณมีตัวเลขใกล้เคียงกัน แสดงว่าการฝึกของคุณสำเร็จ!

+

+{/if}

+

+{#if fw === 'pt'}

+

+### การกำหนดโมเดล[[การกำหนดโมเดล]]

+